آییننامهی اخلاقپژوهانه برای هوش مصنوعی اطمینانبخش

صاحبانِ منافع فهرست ارزیابی هوش مصنوعی اطمینانبخش را که در فصل سومِ این سند ارائه شده است در معرض آزمایش قرار خواهند داد تا بازخوردهای عملی را گردآوری کنند. نسخهی اصلاحشدهی فهرست ارزیابی، با درنظرگرفتن گزارش بازخوردهای گردآوریشده در مرحلهی آزمایشی، اوایل سال ۲۰۲۰ در کمیسیون اروپا ارائه خواهد شد.

AI HLEG گروه متخصص مستقلی است که کمیسیون اروپا در ژوئن ۲۰۱۸ تأسیس کرده است.

تماس با Nathalie Smuha مدیر هماهنگیِ AI HLEG.

ایمیل: CNECT-HLG-AI@ec.europa

کمیسیون اروپا بروکسل B-1049

سند در ۸ آوریل ۲۰۱۹ به صورت عمومی منتشر شد.

اولین پیشنویس این سند در ۱۸ دسامبر ۲۰۱۸ منتشر شد و در معرضِ رایزنیِ آزاد قرار گرفت که بازخورد بیش از ۵۰۰ مشارکتکننده را به همراه داشت. مایلیم صریحاً و صمیمانه از تمام کسانی قدردانی کنیم که دربارهی پیشنویس اولیه به ما بازخورد دادند تا برای تهیهی این نسخهی اصلاحشده آنها را در نظر بگیریم.

نه کمیسیون اروپا و نه هیچ شخص فعالی از سوی کمیسیون مسئولِ بهرهبریهایی نیست که ممکن است بنابر اطلاعات زیر بدست آمده باشد. محتویات این سندِ کاری تنها بر عهدهی گروه متخصص ارشد هوش مصنوعی (AI HLEG) است. هرچند کارکنان کمیسیون در تهیهی این آییننامهها کمک کردهند، دیدگاههای بیانشده در این سند منعکسکنندهی نظرات AI HLEGهستند و ممکن نیست درهیچ شرایطی منعکسکنندهی موضع رسمیِ کمیسیون اروپا تلقی شود.

اطلاعات بیشتر دربارهی گروه تخصصی ارشد در زمینهی هوش مصنوعی به صورت آنلاین در آدرس زیر در دسترس قرار دارد.

(https://ec.europa.eu/digital – single-market/en/high-level-expert-group- artificial -intelligence).

سیاست استفادهی مجدد از اسناد کمیسیون اروپا را تصمیمِ ۲۰۱۱/۸۳۳/EU تنظیم کرده است (OJ L 330, 14.12.2011, p.39). برای هر گونه استفاده یا تکثیر تصاویر یا سایر مطالبی که ذیل حق چاپ اروپا نیستند، باید مستقیماً از دارندگانِ حق چاپ مجوز دریافت کنید.

چکیدهی اجرایی

هدف از این آییننامه ترویجِ هوش مصنوعی اطمینانبخش است. هوش مصنوعی اطمینانبخش سه مؤلفه دارد که باید درتمام چرخهی حیات این سیستم رعایت شود: ۱. باید قانونمند1 باشد، از تمام مقررات و قوانین اجراپذیر تبعیت کند؛ ۲. باید اخلاقی باشد، تضمین کند که به ارزشها و اصول اخلاقی پایبنداست؛ ۳. باید مستحکم باشد، هم از منظر اجتماعی و هم فنی، زیرا تمام سیستمهای هوش مصنوعی، حتی با نیّات خوب، میتوانند باعثِ آسیبهای غیرعمدی شوند. هر مؤلفه به خودیِ خود ضروری است، اما برای دستیابی به هوش مصنوعی اطمینانبخش کافی نیست. در حالت ایدهآل، هر سه مؤلفه از نظر اجرایی هماهنگی و همپوشانیِ دارند. اگرعملاً تنشهایی میان این مؤلفهها ایجاد شود، جامعه باید برای همسوکردنِ آنها تلاش کند.

این آییننامهها چارچوبی را برای دستیابی به هوش مصنوعیِ اطمینانبخش تعیین میکند. این چارچوب آشکارا به اولین مؤلفهی هوش مصنوعی (قانونمندیِ هوش مصنوعی)2 مرتبط نیست. درعوض، هدفی که دنبال میکند ارائهی راهنمایی دربارهی مؤلفههای دوم وسوم است: پروراندن و ایمنسازی هوش مصنوعیِ اخلاقی و مستحکم. خطاب به تمام صاحب منفعان گفته شده که این آییننامهها در جستجوی آن هستند که با ارائهی راهنمایی دربارهی نحوهی عملیاتیشدن این اصول در سیستمهای فنی ــ اجتماعی از فهرست اصول اخلاقی فراتر روند. راهنما در سه سطح تهیه شده است؛ از امر انتزاعی گرفته، انتزاعیترین مطالب در فصل یکم تا ملموسترین مطالب در فصل سوم و با مثالهایی از موقعیتها و نگرانیهای اساسی پایان مییابد که تمامی سیستمهای هوش مصنوعی به وجود میآورند.

۱.براساس رویکرد مبتنی بر حقوق بنیادین، فصل یکم به شناسایی اصول اخلاقی و ارزشهای همبسته با آنها میپردازد که باید در توسعه، راهاندازی و استفاده از سیستمهای هوش مصنوعی آنها را مدنظر قرار داد.

راهنمای کلیدی برگرفته از فصل یکم:

- توسعه، راهاندازی و استفاده از سیستمهای هوش مصنوعی را به طریقی پیش ببرید که به اصول اخلاقی پایبندباشد: به خودمختاری بشر احترام بگذارد، از آسیب جلوگیری کند، منصفانه و توضیحپذیر باشد. تنشهای احتمالی میان این اصول را بشناسد و آنها را حلوفصل کند.

- بهویژه به موقعیتهای گروههای آسیبپذیرتر مانند کودکان، افراد دارای معلولیت و سایر افرادی توجه داشته باشید که در طول تاریخ از خیلی چیزها بیبهره بودهاند یا اکنون در معرض محرومیت هستند، و توجه ویژه به موقعیتهایی داشته باشید که مشخصهی آنها نامقارنبودنِ قدرت یا اطلاعات است، مانند رابطهی میان کارفرمایان و کارکنان، یا میان مشاغل و مصرفکنندگان.

- بپذیرید با اینکه سیستمهای هوش مصنوعی مزایای قابلتوجهی برای افراد و جامعه به ارمغان میآورند خطرات خاصی هم دارند و ممکن است تأثیر منفی داشته باشند از جمله تأثیراتی که چهبسا پیشبینی، شناسایی یا اندازهگیری آن دشوار باشد (برای مثال دموکراسی، حاکمیت قانون و عدالت توزیعی). در صورت لزوم و متناسب با اهمیت خطرات، معیارهای کافی و وافی برای کاهش این خطرات به کار گرفته شود.

۲. فصل دوم با تکیه بر فصل یکم با فهرستبندی هفت شرطی که سیستمهای هوش مصنوعی باید رعایت کنند راهنمایی را دربارهی نحوهی تحقق هوش مصنوعی اطمینانبخش تهیه میکند. برای عملیاتیکردن آنها از هر روش فنی وغیرفنی میتوان استفاده کرد.

راهنمای کلیدی برگرفته از فصل دوم:

- اطمینان حاصل کنید که توسعه، راهاندازی و استفاده از سیستمهای هوش مصنوعی هفت شرط اساسی برای هوش مصنوعی اطمینانبخش را رعایت میکند: ۱. عاملیت انسانی و نظارت، ۲. استحکام از نظر فنی و ایمنی، ۳. حریم خصوصی و سازماندهی داده، ۴. شفافیت، ۵. تنوع، نبود تبعیض و داشتنِ انصاف، ۶. رفاه اجتماعی و زیستمحیطی و ۷. پاسخگویی

- روشهای فنی و غیرفنی را بررسی کنید تا از اجراییشدن آن شروط اطمینان یابید.

- تحقیق و نوآوری را غنی سازید تا به ارزیابی سیستمهای هوش مصنوعی و تحقق هر چه بیشتر شروط، انتشار نتایج و ایجادکردنِ پرسشهایی برای طیف گستردهای از عمومِ افراد و آموزش نظاممندِ نسل جدیدی از متخصصان در زمینهی اخلاقپژوهیِ هوش مصنوعی کمک کند.

- دربارهی قابلیتها و محدودیتهای هوش مصنوعی به طریقی روشن و پویا اطلاعاتی را به صاحبانمنافع منتقل کنید، امکان تنظیم انتظارات واقعبینانه و شیوهی اجراییشدنِ آن شروط را فراهم سازید. دربارهی این واقعیت که آنها با سیستم هوش مصنوعی سروکار دارند شفافیت داشته باشید.

- قابلیت ردیابی وقابلیتِ بازرسی سیستمهای هوش مصنوعی را بهویژه در بسترها یا موقعیتهای بحرانی آسان کنید.

- صاحبان منافع را در طول چرخهی حیات سیستم هوش مصنوعی درگیر کنید. آموزش و پرورش را غنی سازید؛ به طوری که تمام صاحبان منافع از هوش مصنوعی اطمینانبخش آگاهی یابند و در آن آموزش ببینند.

- توجه داشته باشید که ممکن است بین اصول و شروط مختلف تنشهای اساسی رخ دهد. این معاوضات و راهحلهای آنها را همواره شناسایی، ارزیابی، ثبت و به دیگران منتقل کنید.

۳. فصل سوم فهرستی متقن ولی نهچندان جامع از ارزیابی هوش مصنوعی اطمینانبخش ارائه میدهد وهدفش این است که شروط کلیدی تعیینشده در فصل دوم را اجرایی کند. لازم است که این فهرستِ ارزیابی برای موارد کاربرد خاصِ سیستم هوش مصنوعی طراحی شده باشد.3

راهنمای کلیدی برگرفته از فصل سوم:

- فهرست ارزیابی هوش مصنوعی اطمینانبخش را هنگام توسعه، راهاندازی یا استفاده از سیستمهای هوش مصنوعی برگزیند و آن را با موارد کاربرد خاصی تطبیق دهد که سیستم هوش مصنوعی در آنها به کار رفته است.

- به خاطر داشته باشید که این فهرست ارزیابی هرگز جامع نخواهد بود. تضمینِ هوش مصنوعیِ اطمینانبخش چکلیستی ندارد که با تیک زدن آنها بتوان قابلاعتماد بودن هوش مصنوعی را تضمین کرد، بلکه شناسایی و عملیاتیکردن همیشگیِ شروط ، ارزیابی راهحلها، تضمینِ نتایج مطلوب در تمام طول حیات سیستم هوش مصنوعی و مشارکتدادن صاحبان منافع را نیز شامل میشود.

بخش پایانی این سند نمونههایی از فرصتهای سودمند که باید بهدنبال آن بود و نگرانیهای اساسی را مطرح میکند که سیستمهای هوش مصنوعی به وجود میآورند و باید بهدقت بررسی شوند؛ هدف بخش پایانی این است که برخی از موضوعاتی را عینیت ببخشد که در سرتاسر این چارچوب به آن اشاره شد.

در عینِ این که هدف این آییننامهها این است که بهطورکلی با ایجاد مبنایی همتزاز برای دستیابی به هوش مصنوعی اطمینانبخش، راهنمایی برای کاربردهای هوش مصنوعی ارائه دهند، ولی موقعیتهای مختلف چالشهای متفاوتی را به وجود میآورند. بنابراین، باید بررسی شود که با توجه به وجه ویژگی زمینهای هوش مصنوعی آیا علاوه بر این چارچوب همتزار به رویکرد صنفی4 نیز نیاز است یا خیر.

این آییننامهها قصد ندارند هیچ شکلی از سیاستگذاری یا مقررات کنونی و آتی را جایگزین کنند، همچنین قصد ندارند مانع از معرفی اینگونه امور شوند. آنها باید سندی زنده در نظر گرفته شوند که در طول زمان بازبینی و به روز میشوند تا از ارتباط مداوم آنها با تکامل فناوری، محیطهای اجتماعی و توسعهی تدریجی دانش ما اطمینان حاصل شود. این سند نقطهی شروعی برای بحث دربارهی «هوش مصنوعی اطمینانبخش برای اروپا» است.5

همچنین، این آییننامه قصد دارد فراتر از اروپا، تحقیق، تأمل و بحث در حوزهی چارچوب اخلاقی برای سیستمهای هوش مصنوعی را در سطح جهانی غنی سازد.

مقدمه

کمیسیون اروپا در بیانیهی خود در ۲۵ آوریل و ۷ دسامبر ۲۰۱۸ دورنمای خود را دربارهی هوش مصنوعی تنظیم کرد که از«هوش مصنوعیِ اخلاقی، ایمن و پیشرو ساختِ اروپا» پشتیبانی میکند. سه رکن زیربنایی دورنمای کمیسیون عبارتند از: ۱.افزایش سرمایهگذاریهای دولتی و خصوصی در هوش مصنوعی برای گسترش مقبولیت از عرضهی آن، ۲.آمادهسازی برای تغییرات اقتصادی و ۳.تضمینِ چارچوب اخلاقی وقانونمند مناسب برای تقویت ارزشهای اروپایی.

کمیسیون برای پشتیبانی از اجرای این دورنما گروه متخصصان ارشد در زمینهی هوش مصنوعی را تشکیل داد (AI HLEG)، گروهی مستقل که به تهیهی پیشنویسِ دو دستاورد موظف بود: اولی، آییننامههای اخلاقیِ هوش مصنوعی و دومی توصیهنامههای مربوط به سیاست و سرمایهگذاری.

این سند حاوی آییننامههای اخلاقی هوش مصنوعی است که پس از بررسیِ بیشتر در گروهِ ما، با توجه به بازخورد دریافتشده از رایزنی عمومی دربارهی پیشنویس منتشرشده در ۱۸ دسامبر ۲۰۱۸ بازنگری شده است. این آییننامه نتیجهی کارِ گروه اروپایی در حوزهی اخلاقپژوهی در علم و فناوریهای جدید است و از سایر تلاشهای مشابه نیز الهام گرفته است.

طیِ ماههای گذشته، ۵۲ نفر از ما با تعهد به شعار اروپاییِ: متحد با وجود تنوع، با یکدیگر ملاقات، بحث و ارتباط برقرار کردیم. ما معتقدیم که هوش مصنوعی این ظرفیت را دارد که جامعه را بهطرز قابلتوجهی متحول کند. هوش مصنوعی به خودیِخود هدف نیست، بلکه ابزاری امیدبخش برای افزایش ترقی انسان ودرنتیجه بالارفتنِ میزانِ رفاه فردی اجتماعی و خیر عمومی است؛ همچنین پیشرفت و نوآوری را به ارمغان میآورد. بهخصوص، سیستمهای هوش مصنوعی میتوانند به تسهیلِ دستیابی به اهداف پایدار سازمان ملل [برای محیط زیست] کمک کنند، مانند ترویج توازن جنسیتی، حلکردن تغییرات آبوهوایی، استفادهی بهینه و منطقی از منابع طبیعی، افزایش سلامت ما، تغییرپذیری و فرآیندهای تولید و از نحوهی نظارت بر پیشرفت در مقابلِ پایدارسازی و انسجام اجتماعی پشتیبانی کند.

برای تحقق این امر، سیستمهای هوش مصنوعی باید انسانمحور باشند و مبتنی بر تعهد به استفاده از آنها در خدمت به بشر و خیر عمومی باشند و هدفشان بهبود رفاه و آزادی انسان باشد. سیستمهای هوش مصنوعی در حالی که فرصتهای خیلی خوبی را فراهم میکنند، خطرات خاصی هم دارند که باید به شکلی مناسب و درخور مهار شوند. ما اکنون دریچهای از فرصتهای مهم را برای شکلدادن به توسعهی آنها در اختیار داریم. ما میخواهیم مطمئن شویم که میتوانیم به محیطهای فنی ـ اجتماعی اعتماد کنیم که سیستمهای هوش مصنوعی در آن به کار رفتهاند. همچنین، ما از تولیدکنندگانِ سیستمهای هوش مصنوعی میخواهیم که با به کارگیریِ هوش مصنوعی اطمینانبخش در تولیدات و خدمات خود در رقابت به برتری دست یابند. این امر مستلزم آن است که تلاش شود مزایای سیستمهای هوش مصنوعی به بیشترین میزان برسد و همزمان ازخطرات آنها جلوگیری شود و به کمترین میزان برسد.

ما معتقدیم در بسترِ تغییرات فنی سریع، ضروری است که اعتماد پایهی جوامع، اجتماعات، اقتصادها و توسعهی پایدار باشد. بنابراین، ما هوش مصنوعی اطمینانبخشِ را جاهطلبیِ بنیادینِ خود میدانیم، زیرا انسانها و اجتماعات تنها زمانی میتوانند به توسعهی فناوری و کاربردهای آن اعتماد داشته باشند که چارچوبی روشن و جامع برای دستیابی به اطمینانبخشیِ آن آماده به کار باشد.

این مسیری است که ما باور داریم اروپا باید طی کند تا خاستگاه و رهبر فناوری پیشرفته و اخلاقی باشد. از طریق هوش مصنوعیِ اطمینانبخش است که ما شهروندان اروپایی در جستجوی بهرهمندی از مزایای آن به روشی خواهیم بود که با ارزشهای اساسیِ احترام به حقوق بشر، دموکراسی و حاکمیت قانون همسو باشد.

هوش مصنوعی اطمینانبخش

اطمینانبخشی برای مردم و جوامع جهتِ توسعه، راهاندازی و استفاده از سیستمهای هوش مصنوعی شرط لازم است. بدون اینکه سیستمهای هوش مصنوعی ــ و انسانهایی که پشت آن قرار دارند ــ واقعاً شایستهی اعتماد باشند چهبسا عواقب ناخواستهای به وجود بیاید و مانعِ استقبال ازعرضهی آنها بشود، از تحقق منافع اقتصادی و اجتماعیِ احتمالاً زیادی جلوگیری کند که آنها میتوانند به ارمغان بیاورند. دورنمای ما برای کمک به اروپا در تحققبخشیدن به آن منافع این است که تحقق هوش مصنوعی اطمینانبخش را تضمین کنیم و بر میزان اطمینانبخشیِ آن بیفزاییم.

اطمینان در توسعه، راهاندازی و استفاده از سیستمهای هوش مصنوعی به ویژگیهای نهادینه در فناوری مرتبط نیست، بلکه به کیفیت سیستمهای فنی ـ اجتماعیای مرتبط است که در برنامههای کاربردی هوش مصنوعی دخالت دارند. درست مثل مسائل مربوط به (فقدان) اعتماد در ساخت وسایلِ هوانوردی، قدرت انرژی هستهای یا سالمبودن غذا [باید گفت که] فقط مؤلفههای سیستم هوش مصنوعی نیستند که ممکن است موجب اطمینان یا فقدان اطمینان شوند، بلکه سیستم در بسترِ کلی خودش موجب اطمینان یا فقدان اطمینان میشود. ازاینرو، تلاش برای دستیابی به هوش مصنوعی اطمینانبخش نهتنها به اطمینانبخشیِ خودِ سیستم هوش مصنوعی مربوط میشود، بلکه نیازمند رویکردی نظاممند و کلنگر است که اطمینانبخشیِ تمام فعالان و فرآیندهایی را در نظر داشته باشد که بخشی از بستر فنی ـ اجتماعی در سرتاسر چرخهی حیات آن باشد.

اطمینانبخشیِ هوش مصنوعی سه مؤلفه دارد که باید در سرتاسر چرخهی حیات سیستم رعایت شود:

- باید قانونمند باشد، از تمام مقررات و قوانینِ اجراپذیر تبعیت کند؛

- باید اخلاقی باشد، تضمین کند که به ارزشها و اصول اخلاقی پایبنداست؛ و

- باید مستحکم باشد، هم از منظر اجتماعی و هم فنی، زیرا تمام سیستمهای هوش مصنوعی، حتی با نیّات خوب، میتوانند باعثِ آسیبهای غیرعمدی شوند.

هر یک از این سه مؤلفه ضروری است، اما برای دستیابی به هوش مصنوعی اطمینانبخش کافی نیست. در حالت ایدهآل هر سه مؤلفه هماهنگ با هم کار میکنند و عملکردشان همپوشانی دارد. با این حال، ممکن است عملاً بین این عناصر تنشهایی وجود داشته باشد (مثلاً گاهی اوقات حوزه و محتوای قوانین موجود ممکن است با هنجارهای اخلاقی هماهنگ نباشد). این مسئولیت فردی و جمعی ماست که در جامعه در جهتی کار کنیم که اطمینان یابیم هر سه مؤلفه به ۱۱ مؤلفهی ایمنی هوش مصنوعیِ اطمینانبخش کمک میکنند.

یکی از رویکردهای اطمینانبخش کلیدِ فعالکردن «رقابتپذیری مسئولانه» است از طریق فراهمکردن مبنایی که بر اساس آن تمام افرادِ تحت تأثیر سیستمهای هوش مصنوعی بتوانند تضمین کنند که طراحی، توسعه و استفاده از هوش مصنوعی قانونمند، اخلاقی و مستحکم است. این آییننامهها را بهمنظور غنیسازی ابداعِ هوش مصنوعیِ مسئول و پایدار در اروپا در نظر گرفتهاند. آنها بهدنبال این هستند که اخلاقپژوهی را به ستون اصلی برای توسعهی رویکردی منحصربهفرد به هوش مصنوعی تبدیل کنند، رویکردی که هدفش سودرساندن، قدرتمندسازی و محافظت هم از شکوفایی فردی انسان است و هم خیر همگانی جامعه. ما معتقدیم که این امر به اروپا امکان میدهد تا خودش را بهعنوان رهبر جهانی در زمینهی هوش مصنوعی پیشرفته و شایان اطمینان جمعی و فردی ما قرار دهد. اروپاییان تنها با تضمینِ اطمینانبخشی ، با علم به اینکه معیارهایی آماده به کار برای محافظت در برابر خطرات احتمالی آن سیستمها وجود دارد، کاملاً از مزایای سیستمهای هوش مصنوعی بهرهمند خواهند شد.

همانطور که استفاده از سیستمهای هوش مصنوعی در مرزهای ملی بازنمیایستد، تأثیرات آنها نیز متوقف نمیشود. بنابراین، برای موقعیتها و چالشهایی که سیستمهای هوش مصنوعی به وجود میآورند راهحلهای جهانی نیز لازم است. بنابراین، ما تمامی صاحبان منافع را تشویق میکنیم تا در راستای چارچوبی جهانی برای رسیدن به هوش مصنوعی اطمینانبخش کار کنند و در عین اینکه رویکرد مبتنی بر حقوق اساسی ما [مصرفکنندگان] را ترویج و از آن حمایت میکنند در سطح بینالملل اجماع به وجود آورند.

مخاطب و دامنه

این آییننامهها خطاب به تمام صاحبان منافع در مراحل طراحی، توسعه، راهاندازی اجرا، استفاده یا هر گونه تأثیرپذیرفتن از هوش مصنوعی از جمله شرکتها، ارگانها، پژوهشگران، خدمات عمومی، آژانسهای دولتی، نهادها، سازمانهای جامعهی مدنی، افراد، کارکنان و مصرفکنندگان تنظیم شدهاند، ولی به اینها هم محدود نیست.

صاحبان منافعی که به دستیابی به هوش مصنوعی اطمینانبخش متعهدند میتوانند داوطلبانه از این آییننامهها به عنوان روشی برای عملیاتیکردن تعهدات خود استفاده کنند، بهخصوص، با استفاده از فهرست ارزیابی عملی فصل سوم بههنگام توسعه، راهاندازی یا استفاده از سیستمهای هوش مصنوعی. این فهرست ارزیابی میتواند مکملِ فرآیندهای ارزیابی موجود و درنتیجه به آنها ضمیمه شود.

هدف آییننامه این است که بهطورکلی راهنمایی برای کاربردهای هوش مصنوعی باشد، مبنایی همتراز برای دستیابی به هوش مصنوعی اطمینانبخش ایجاد کند. با این حال، موقعیتهای مختلف چالشهای متفاوتی را ایجاد میکنند. سیستمهای پیشنهاد موسیقی هوش مصنوعی همان دغدغههای اخلاقی را ایجاد نمیکنند که در درمانهای پزشکی حیاتی مطرح میشود. به همین ترتیب، فرصتها و چالشهای مختلفی از سیستمهای هوش مصنوعی به وجود میآید که در بستر تجارت شرکت ـ با ـ مصرفکننده، تجارت شرکت ـ با ـ تجارت شرکت، کارفرما ـ با ـ کارمند و روابط عمومی ـ با ـ شهروندی یا بهطور کلی، در بخشها یا نمونههای متفاوت استفاده میشود. با توجه به خاصبودنِ بستر سیستمهای هوش مصنوعی، اجراییشدن این آییننامه نیازمند تطبیق آنها با کاربرد خاصِ هوش مصنوعی است. علاوه بر این، ضرورت رویکرد سنفی اضافه برای تکمیل چارچوب همتراز کلیتر که در این سند پیشنهاد شده باید بررسی شود.

برای رسیدن به فهمی بهتر از چگونگی اجرای این آییننامه در سطح همتراز و مواردی که نیازمند رویکرد صنفی هستند، ما از تمام صاحبان منافع دعوت میکنیم تا فهرست ارزیابی هوش مصنوعی اطمینانبخش (فصل سوم) را آزمایش کنند تا این چارچوب را عملیاتی کنند و به ما بازخورد دهند. بر اساس بازخوردهای جمعآوریشده در این مرحلهی آزمایشی، ما فهرست ارزیابیِ این آییننامهها را تا اوایل سال ۲۰۲۰ بازبینی خواهیم کرد. مرحلهی آزمایشی تا تابستان ۲۰۱۹ راهاندازی شده و تا پایان سال ادامه خواهد داشت. تمام صاحبان منافعِ علاقهمند میتوانند با اشاره به علاقهی خود از طریق اتحادیهی هوش مصنوعی اروپا در مرحلهی آزمایشی شرکت کنند.

ب.چارچوبی برای هوش مصنوعی اطمینانبخش

این آییننامهها برای دستیابی به هوش مصنوعی اطمینانبخش بر اساس حقوق اساسی منتشرشده درمنشور حقوق اساسیِ اتحادیهی اروپا (EU Charter) و قوانین بینالمللی حقوق بشر چارچوبی را بیان میکنند. در زیر خلاصهوار به سه مؤلفهی هوش مصنوعی اطمینانبخش اشاره میکنیم:

هوش مصنوعی قانونمند

سیستمهای هوش مصنوعی در جهانی بدونِ قانونمندی اجرا نمیشوند. تعدادی از قواعد الزامآور بهلحاظ قانونی در حال حاضر در میان اروپاییان در سطح ملی و بینالمللی اجرا میشوند یا امروزه به توسعه، راهاندازی و استفاده از سیستمهای هوش مصنوعیِ مرتبط هستند. منابع قانونی6 عبارتند از موارد زیر، ولی محدود به این موارد هم نیست: قانون اولیهی اتحادیه اروپا (معاهداتِ اتحادیه اروپا و منشور حقوق اساسی آن)، قوانین ثانویهی اتحادیه اروپا (مانند مقررات حفاظت از دادههای عمومی، دستورالعمل مربوط به تعهد نسبت به فرآورده، مقررات مربوط به جریان آزاد دادههای غیرشخصی، دستورالعملهای ضدِ تبعیض، قوانین مربوط به مصرفکننده و دستورالعملهای مربوط به ایمنی و بهداشت در محل کار)، معاهدات حقوق بشری سازمان ملل متحد و کنوانسیونهای شورای اروپا (از جمله کنواسیون حقوق بشر)، و قوانین متعددِ ایالات عضو اتحادیهی اروپا. علاوه بر این قوانینِ کاربردیِ همتزار، قوانین متعددِ حوزهای خاص نیز وجود دارند که برای برنامههای کاربردیِ خاص هوش مصنوعی (برای مثال برای مقررات مربوط به تجهیزات پزشکی در بخش مراقبتهای بهداشتی) به کارمیرود.

قانون هم تکالیف سلبی و هم ایجابی را ارائه میدهد، به این معنا که این قوانین را نهتنها باید با ارجاع به چیزی تفسیر کرد که نمیتوان انجام داد، بلکه باید با ارجاع به چیزی تفسیر کرد که باید انجام داد و یا انجام آن ممکن است. قانون نهتنها مانع انجام برخی اعمال میشود، بلکه همچنین برخی دیگر از اعمال را میسر میسازد. در این راستا، میتوان اشاره کرد که منشور اتحادیه اروپا شامل مقالاتی درباب «آزادی در انجام تجارت» و «آزادی هنرها وعلوم» میشود، مقالاتی طولانی که به حوزههایی مانند حفاظت از دادهها و نبود تبعیض میپردازند که هنگام جستجویِ تضمینی برای هوش مصنوعیِ اطمینانبخش بیشتر با آن هستیم.

حوزههایی مانند حفاظت از دادهها و نبود تبعیض میپردازند که هنگام جستجویِ تضمینی برای هوش مصنوعیِ اطمینانبخش بیشتر با آن هستیم.

آییننامهها صراحتاً به اولین مؤلفهی هوش مصنوعی اطمینانبخش (یعنی هوش مصنوعی قانونمند) نمیپردازند، بلکه درعوض هدف از آنها ارائهی راهنمایی در زمینهی پروراندن و تضمینِ مؤلفههای دوم وسوم (هوش مصنوعی اخلاقی و مستحکم) است. در حالی که دومی تا حدی قبلاً در قوانین موجود منعکس شده است، تحقق کامل آنها ممکن است از تکالیف قانونی موجود فراتر رود.

هیچ چیزی در این سند نباید بهگونهای تلقی یا تفسیر شود که ارائهدهندهی مشاوره یا راهنمایی حقوقی باشد دربارهی این که چگونه میتوان از تمام هنجارها و شروط قانونی موجود تبعیت کرد. هیچ چیزی در این سند نه باید حقوق قانونی ایجاد کند و نه تکالیف قانونی بر اشخاص ثالث تحمیل کند. با این حال، یادآوری میکنیم که این وظیفهی هر شخص ثالث حقیقی یا حقوقی است که از قوانین پیروی کند ـ چه امروزه اجراپذیر باشند و چه با توجه به توسعهی هوش مصنوعی در آینده به تصویب برسند. این آییننامهها با این پیشفرض همراهند که تمام تکالیف و حقوق قانونی که به فرآیندها و فعالیتهایی اطلاق میشوند که به توسعه، راهاندازی و استفاده از سیستمهای هوش مصنوعی مربوطند، الزامی باقی میمانند و باید بهدرستی رعایت شوند.

هوش مصنوعی اخلاقی

دستیابی به هوش مصنوعی اطمینانبخش فقط مستلزم تبعیت از قانون نیست که البته یکی از سه مؤلفهی آن است. قوانین همیشه با توسعههای فناوری همرده نیستند، گاهی اوقات قوانین ممکن است با هنجارهای اخلاقی همخوانی نداشته باشند یا صرفاً برای رسیدگی به برخی مسائل مناسب نباشند.ازاینرو، برای اینکه سیستمهای هوش مصنوعی اطمینانبخش باشند، باید اخلاقی باشند و همسویی با هنجارهای اخلاقی را تضمین کنند.

هوش مصنوعی مستحکم

حتی اگر هدف اخلاقی تضمین شود، افراد و جامعه باید خاطرجمع باشند که سیستمهای هوش مصنوعی باعث ایجاد هیچ آسیب غیرعمدی نمیشوند. چنین سیستمهایی باید به طریقی قابلاعتماد، ایمن و تضمینشده عمل کنند و برای جلوگیری از هرگونه تأثیرات نامطلوبِ غیرعمدی اقدامات حفاظتی بایستی پیشبینی شود. بنابراین، مهم است که اطمینان حاصل شود تمام سیستمهای هوش مصنوعی مستحکم هستند. این امر هم از منظر فنی (تضمین دوام فنی سیستم به شکل مناسب در بستری معین، مانند حوزهی کاربرد یا مراحل چرخهی حیات) الزامی است، و هم از منظر اجتماعی (با درنظرگرفتن بستر و محیطی که سیستم در آن عمل میکند).

ازاینرو، ویژگیهای اخلاقی و مستحکم در هوش مصنوعی کاملاً درهمتنیده و مکمل همدیگرند. اصول مطرح در فصل اول وشروط برگرفته از این اصول در فصل دوم به هر دو مؤلفه میپردازند.

چارچوب

راهنمای این سند در سه فصل ارائه شده است، از انتزاعیترین امر در فصل اول گرفته تا ملموسترین امر در فصل سوم:

- فصل اول ــ مبانی هوش مصنوعی اطمینانبخش: مبانی هوش مصنوعی اطمینانبخش را با طرح رویکردی مبتنی بر حقوق اساسی آن تنظیم میکند. این فصل اصول اخلاقی را شناسایی و توصیف میکند که برای تضمینِ هوش مصنوعی مستحکم واخلاقی باید رعایت شوند.

- فصل دو ــ تحقق هوش مصنوعی اطمینانبخش: اصول اخلاقی را بهصورت هفت تا از شروط اساسی ترجمه میکند که سیستمهای هوش مصنوعی باید در تمام چرخهی حیات خود اجرا و برآورده کنند. علاوه براین، روشهای فنی و غیرفنی را ارائه میدهد که میتواند هنگام اجراییشدن آنها به کار رود.

- فصل سوم ــ ارزیابی هوش مصنوعی اطمینانبخش: فهرستی مشخص و نه چندان جامع دربارهی ارزیابیِ هوش مصنوعی اطمینانبخش، بهمنظور عملیاتیکردن شروط فصل دوم، ارائه میکند و راهنمایی عملی را در دسترس متخصصان هوش مصنوعی قرار میدهد. این ارزیابی باید متناسب با برنامهی کاربردی این سیستم خاص باشد.

بخش نهایی این سند مثالهایی از فرصتهای سودمند و نگرانیهایی اساسی را فهرستبندی میکند که در هوش مصنوعی مطرح شده است و باید از این فرصتها و نگرانیها برای برانگیختنِ بحثهای بیشتر در این حوزه استفاده کرد.

فصل یکم: مبانی هوش مصنوعی اطمینانبخش

این فصل مبانی هوش مصنوعی اطمینانبخش را تنظیم میکند که بر پایهی حقوق اساسی استوار است و در چهار اصل اخلاقی منعکس شده است که باید به منظور تضمین هوش مصنوعی اخلاقی و مستحکم رعایت شوند. این فصل بسیار زیاد به حوزهی اخلاقپژوهی میپردازد.

اخلاقپژوهی در حوزهی هوش مصنوعی زیرمجموعهای از اخلاقپژوهی کاربردی است که بر مسائل اخلاقی ناشی از توسعه، راهاندازی و استفاده از هوش مصنوعی تمرکز دارد. دغدغهی اساسی اخلاقپژوهی تشخیص این امر است که هوش مصنوعی چگونه میتواند زندگی خوب افراد را ارتقا دهد یا دغدغههایی مرتبط با آن را به بار آورد، چه دربارهی کیفیت زندگی، یا خودمختاری انسان و آزادی ضروری برای جامعهی دموکراتیک.

تأمل اخلاقی دربارهی فناوری هوش مصنوعی میتواند اهداف متعدی را دنبال کند. اول اینکه، میتواند تأملاتی دربارهی نیاز به حفاظت از افراد و گروهها را در اساسیترین سطح آن برانگیزاند. دوم اینکه میتواند انواع جدیدی از نوآوریها را برانگیزاند که به دنبال تقویت ارزشهای اخلاقی هستند، از جمله آن [برنامههای ابداعی] که در دستیابی به اهداف توسعهی پایدار سازمان ملل متحد کمک میکنند که عمیقاً در دستور کار آیندهی اتحادیه اروپا در سال ۲۰۳۰ گنجانده شده است. در حالی که این سند بیشتر به هدف اولی پرداخته است که مطرح شد، اهمیتی را که اخلاقپژوهی در هدف دوم میتواند داشته باشد نباید دستِ کم گرفت. هوش مصنوعی اطمینانبخش با تولید رفاه، آفرینش ارزش و رساندن ثروت به بیشترین حد میتواند شکوفایی فردی و رفاه جمعی را بهبود دهد. هوش مصنوعی میتواند با کمک به افزایش سلامت شهروندان و رفاه آنها در راه رسیدن به جامعهای منصفانه کمک کند به طریقی که به بیشترشدنی برابری در فرصتهای توزیع اقتصادی، اجتماعی وسیاسی کمک کند.

بنابراین، ضروری است که بدانیم چگونه از توسعه، راهاندازی و استفاده از هوش مصنوعی به بهترین شکل حمایت کنیم تا اطمینان یابیم که همه میتوانند در جهانی بر پایهی هوش مصنوعی پیشرفت کنند و آیندهی بهتری بسازند و در عین حال در سطح جهانی رقیب یکدیگر باشند. استفاده از هوش مصنوعی مانند هر فناوری قدرتمند دیگری در جامعهی ما چالشهای اخلاقی متعددی را به بار میآورد، برای مثال، در رابطه با تأثیر آنها بر مردم و جامعه، قابلیتهای تصمیمگیری و ایمنی. اگر قرار است ما روزبهروز از دستیاریِ سیستمهای هوش مصنوعی بیشتر استفاده کنیم یا تصمیمات را به آنها بسپاریم باید مطمئن شویم که این سیستمها تأثیرگذاری نسبتاً خوبی بر زندگی مردم دارند و این که مطابق با ارزشهایی هستند که نباید به خطر بیفتند و قادرند بر اساس آن عمل کنند و این که فرآیندهای مناسبِ پاسخگویی میتوانند چنین چیزی را تضمین کنند.

اروپا باید مشخص کند که قصد دارد چه دورنمای هنجاری از آیندهی غوطهور در هوش مصنوعی را تحقق بخشد و بفهمد دربارهی کدام مفهوم از هوش مصنوعی باید در اروپا پژوهش شود، توسعه یابد، راهاندازی و استفاده شود تا به این دورنما دست یابد. با این سند قصد داریم از طریق معرفی مفهوم هوش مصنوعی اطمینانبخش در مسیرِ چنین تلاشی مشارکت کنیم که به باور ما راه درستی برای ساخت آیندهای با حضور هوش مصنوعی است. آیندهای که در آن دموکراسی، حاکمیت قانون و حقوق اساسی زیربنای سیستمهای هوش مصنوعی باشد و چنین سیستمهایی همواره فرهنگ دموکراتیک را بهبود بخشند و از آن دفاع کنند، همچنین محیطی را ایجاد کنند که در آن نوآوری و رقابت مسئولانه امکان رشد دارد.

منشور اخلاقیِ حوزهای خاص ــ هرچند نسخههای آتی آن چهبسا سازگار، توسعهیافته و دقیق باشند ــ هرگز نمیتواند بدیلی برای خود استدلال اخلاقی باشد که همیشه باید به جزئیات وابسته به بستر حساس باقی بماند که نمیتواند در آییننامهی کلی درج شود. فراتر از توسعهی مجموعهای از قوانین، تضمینِ هوش مصنوعی اطمینانبخش ما را ملزم میکند تا از طریق بحث همگانی، آموزش و یادگیری عملی، فرهنگ و طرز فکری اخلاقی را ایجاد و حفظ کنیم.

۱. حقوق اساسی در مقام استحقاقِ اخلاقی و قانونی

ما به رویکرد اخلاقپژوهانهای درهوش مصنوعی باور داریم که مبتنی بر حقوق اساسی مندرج در معاهدات اتحادیه اروپا و قوانین بینالمللی حقوق بشر باشد. احترام به حقوق اساسی درون چارچوب دموکراسی و حاکمیت قانون امیدوارکنندهترین مبانی را برای شناسایی ارزشها و اصول اخلاقی انتزاعی فراهم میآورد که میتواند در چارچوب هوش مصنوعی اجرا شود.

معاهدات و منشور اتحادیه اروپا مجموعهای از حقوق اساسی را تجویز میکنند که کشورهای عضو اتحادیه اروپا و نهادهای آن هنگام اجراییشدنِ قوانین اتحادیه اروپا از نظر قانونی مکلّف به رعایت آنها هستند. این حقوق در منشور اتحادیه اروپا با اشاره به کرامت، آزادی، برابری و همبستگی، حقوق شهروندی و عدالت توصیف شده است. بنیانِ مشترکی که این حقوق را یکی میسازد میتوان امری دانست که در احترام به کرامت انسانی قابل فهم است ــ در نتیجه بازتابندهی چیزی است که ما در «رویکرد انسان محور» توصیف میکنیم که در آن انسانها از شأن اخلاقیِ برترِ منحصربهفرد و انکارناپذیر در زمینههای مدنی، سیاسی، اقتصادی و اجتماعی برخوردارند.

در عینِ این که حقوقی که در منشور اتحادیه اروپا تنظیم میشوند از نظر قانونی الزامآورند، مهم است این امر به رسمیت شناخته شود که حقوق اساسی از هر موردی حمایت قانونی جامعی نمیکنند. در منشور اتحادیه اروپا، برای مثال، تأکید بر این نکته اهمیت دارد که حوزهی کاربرد آن محدود به حیطههایی از قانون اتحادیه اروپا باشد. قوانین بینالمللیِ حقوق انسانی و بخصوص کنوانسیون اروپایی حقوق بشر از لحاظ قانونی برای ایالاتی الزامآورند که عضو اتحادیه اروپا باشند، از جمله حیطههایی که خارج از محدودهی قوانین اتحادیه اروپا هستند. در عین حال، حقوق اساسی نیز بنا بر شأن اخلاقی افراد و گروهها در جایگاه انسان و مستقل از قوای قانونی آنها (تا حد معینی) به آنها اعطاء میشود. بنابراین، [زمانی که] حقوق اساسی در مقامِ حقوق قانونیِ اجراپذیر فهم میشوند، تحت تأثیر اولین مؤلفه از هوش مصنوعی اطمینانبخش (هوش مصنوعی قانونمند) قرار میگیرند که ضامنِ تبعیت از قانون است و [زمانی که] در مقام حقوق همگانی فهم میشوند که در شأن اخلاقیِ ذاتیِ انسانها ریشه دارد، زیربنای دومین مؤلفه هوش مصنوعی اطمینانبخش (هوش مصنوعی اخلاقی) قرار میگیرند و با هنجارهای اخلاقی سروکار پیدا میکنند که ضرورتاً از نظر قانونی الزامآور نیستند، با این حال برای تضمینِ اطمینانبخشبودن هوش مصنوعی حیاتی هستند. از آنجایی که هدفِ این سند ارائهی راهنمایی دربارهی مؤلفهی اول نیست، برای رسیدن به اهداف این آییننامههایی که الزامآور نیستند، ارجاع به حقوق اساسی مؤلفهی دوم را انعکاس میدهد.

۲.از حقوق اساسی تا اصول اخلاقی

۱ـ۲ حقوق اساسی، مبنایی برای هوش مصنوعیِ اطمینانبخش

در میان مجموعهی جامعی از حقوقِ یکپارچه که در قوانین بینالمللیِ حقوق بشر تنظیم شده است، معاهدات اتحادیه اروپا و منشور اتحادیه اروپا، خانوادههای ذیلِ این حقوق اساسی، بخصوص برای پوشش سیستمهای هوش مصنوعی مناسب هستند. بسیاری از این حقوق، در شرایط ویژه، از نظر قانونی در اتحادیه اروپا اجراپذیر هستند، به طوری که پیروی از شرایط آنها از نظر قانونی الزامآور است. اما حتی پس از پیروی از حقوق اساسی که به لحاظ قانونی اجراپذیر هستند، تأمل اخلاقی میتواند به ما کمک کند تا بفهمیم چگونه توسعه، راهاندازی و استفاده از سیستمهای هوش مصنوعی ممکن است بر حقوق اساسی و ارزشهای بنیادین تأثیر بگذارد و زمانی که بهدنبال آنیم بفهمیم با فناوری چه باید بکنیم به جای اینکه بفهمیم (درحال حاضر) با فناوری چه میتوانیم بکنیم، تأمل اخلاقی میتواند به ارائهی راهنمای دقیقتر [در این شرایط] به ما کمک کند.

احترام به کرامت انسانی: کرامت انسانی مبتنی بر این ایده است که هر انسانی «ارزش ذاتی» دارد که نه دیگران و نه فناوریهای جدید مانند سیستمهای هوش مصنوعی هرگز نباید آن را تحقیر کنند، به آن لطمه بزنند یا آن را سرکوب کنند. در این زمینه، احترام به کرامت انسانی مستلزم این است که با همهی افراد در جایگاه سوژههای اخلاقی رفتار شود، نه اینکه صرفاً ابژههایی در نظر گرفته شوند که باید اَلک، دستهبندی، نمرهگذاری، گلهای و شرطی شوند یا بازیچه باشند. ازاینرو، سیستمهای هوش مصنوعی باید به طریقی توسعه یابند که به تمامیت جسمانی و ذهنی انسانها، حسِ هویتِ فردی و فرهنگی و برآوردن نیازهای اساسی آنها احترام گذارند، در خدمت آنها باشند و از آنها محافظت کنند.

آزای فردی: انسانها باید آزاد بمانند تا برای زندگیشان خودشان تصمیم بگیرند. این امر مستلزم آن است که کسی به عمد آنها را در شرایط ناخواسته قرار ندهد، همچنین مستلزم آزادشدن از مداخلهی حکومت و سازمانهای غیرحکومتی است تا تضمین شود که افراد یا مردمی که در معرض خطر محرومیت هستند به مزایا و فرصتهای حاصل از هوش مصنوعی دسترسی برابرانه دارند. برای مثال آزادی فردی در بستر هوش مصنوعی نیازمند آن است که اجبارِ (غیر)مستقیم به امر غیرقانونی، تهدید به خودمختاریِ ذهنی و سلامت روان، نظارت ناموجّه،فریب و بازیچهشدن به شکلی نامنصفانه کاهش یابد. در واقع، آزادی فردی به معنای تعهد به توانمندسازیِ افراد برای اِعمال کنترل بیشتر بر زندگی خودشان است که (در میان سایر حقوق) شامل حمایت از آزادی در انجام تجارت، آزادی هنرها و علوم، آزادی بیان، حقِ داشتنِ زندگی خصوصی و حریم خصوصی و آزادیِ انجمنها و ائتلافهاست.

احترام به دموکراسی، عدالت و حاکمیت قانون: تمام قدرتهای حکومتی در دموکراسیهای مشروطه باید به لحاظ قانونی مجاز باشند و به قانون محدود باشند. سیستمهای هوش مصنوعی باید در جهت حفظ و پرورشِ فرآیندهای دموکراتیک و احترام به کثرت ارزشها و انتخابهای افراد در زندگی خدمت کنند. سیستمهای هوش مصنوعی نباید فرآیندهای دموکراتیک، رایزنیهای بشر یا سیستمهای رأیدهیِ دموکراتیک را تضعیف کنند. همچنین، در سیستمهای هوش مصنوعی باید تعهدی تعبیه شود که تضمین کند آن سیستمها به روشهایی عمل نمیکنند که تعهدات بنیادینی را که حاکمیت قانون بر آن استوار است و همچنین قوانین و مقررات الزامی را تضعیف کند و فرآیندِ مناسب و برابرانه در مقابل قانون را تضمین کنند.

برابری، یکپارچگی و نبودِ تبعیض: شامل حقوق افرادی میشود که در معرض خطر محرومیت هستند. احترام برابر به ارزش اخلاقی و کرامت تمام انسانها باید تضمین شود. این چیزی فراتر از نبودِ تبعیض است که بر اساس توجیهاتی عینی، تفاوتقائلشدن میان موقعیتهای متفاوت تحمل میشود. برابری، در بستر هوش مصنوعی، متضمن آن است که عملیاتِ سیستم نتایج نامنصفانه و جانبدارانهای به بار نیاورد (برای مثال، دادههای مورداستفاده در آموزش سیستمهای هوش مصنوعی باید تا حد امکان گروههای مختلف جمعیتی را پوشش دهد). این امر همچنین، مستلزم احترام کافی به افراد و گروههایی است که بالقوه آسیبپذیرند، مانند کارگران، زنان، افراد دارای معلولیت، اقلیتهای قومی، کودکان، مصرفکنندگان یا سایر افرادی که در معرض محرومیت قرار دارند.

سیستمهای هوش مصنوعی باید رفاه فردی و جمعی را بهبود دهند. این بخش چهار اصل اخلاقی را فهرست میکند که ریشه در حقوق اساسی دارد و باید آنها را رعایت کرد تا تضمینی باشد برای اینکه سیستمهای هوش مصنوعی به طریقی اطمینانبخش توسعه یافته، راهاندازی شده و به کار رفتهاند. آنها بهعنوان شروط اخلاقی تعیین شدهاند، به طوری که متخصصانِ هوش مصنوعی همواره در پایبندی به آنها تلاش میکنند. ما بدون اینکه سلسلهمراتبی تعیین کنیم، اصولی را در ادامه به طریقی فهرستبندی کردهایم که بازتاباندهی نظم ظاهریِ حقوق اساسیای است که منشور اتحادیه اروپا مبتنی بر آن است.

این اصول اولیه عبارتند از :

۱.احترام به خودمختاری انسان

۲.پیشگیری از آسیب

۳.انصاف

۴.توضیحپذیری

بسیاری از این موارد تا حد زیادی از قبل در شروط قانونی موجود منعکس شده است که پیروی از آنها الزامآور است و ازاینرو در حوزهی هوش مصنوعی قانونمند قرار میگیرند که اولین مؤلفهی هوش مصنوعیِ اطمینانبخش است. با این حال، همانطور که در بالا مطرح شد، در حالی که بسیاری از تکالیف قانونی بازتاباندهی اصول اخلاقی هستند، پایبندی به اصول اخلاقیِ فراتر از پیروی رسمی از قوانین موجود است.

.اصل احترام به خودمختاریِ انسان

حقوق اساسیای که اتحادیه اروپا بر آن مبتنی است باز هم به سمت تضمینِ احترام به آزادی و خودمختاری انسانها هدایت میشود. انسانهایی که با سیستمهای هوش مصنوعی ارتباط متقابل دارند باید بتوانند حقِ تعیینِ سرنوشت خویش را به شکل کامل و مؤثر حفظ کنند و در فرآیند دموکراتیک سهیم باشند. سیستمهای هوش مصنوعی نباید انسانها را بهطورناموجّه انسانها را فرمانبردار کنند، بهزور به انجام کاری وادارند، فریب دهند، آنها را بازیچه کنند، شرطی سازند یا گلهوار سازند. درعوض، آنها باید برای تقویت، تکمیل و توانمندسازی در مهارتهای شناختی، اجتماعی و فرهنگی انسان طراحی شوند. تقسیم کارکردها میان انسانها و سیستمهای هوش مصنوعی باید تابعِ اصول طراحیِ انسانمحور باشند و فرصت معناداری را برای انتخاب انسان فراهم کنند. این به معنای تضمینِ نظارت انسان بر فرآیندهای کاری در سیستمهای هوش مصنوعی است. همچنین، سیستمهای هوش مصنوعی ممکن است حوزهی کاری را از اساس تغییر دهند. این سیستمها باید از انسانها در محیط کاری حمایت کنند و هدفشان ایجاد کاری معنادار باشد.

.اصل جلوگیری از آسیب

سیستمهای هوش مصنوعی نباید باعث آسیب یا تشدید آسیب بر انسانها شوند یا باعث ایجاد آثار نامطلوب بر انسانها شوند. این امر مستلزم حفظ کرامت انسانی و نیز تمامیت روحی و جسمی است. سیستمهای هوش مصنوعی و محیطهایی که در آن کار میکنند باید امن و ایمن باشند. آنها باید از نظر فنی مستحکم باشند و این اطمینان حاصل شود که آنها در معرض استفادهی بدخواهانه نیستند. افراد آسیبپذیر باید بیشتر موردتوجه قرار گیرند و در توسعه، راهاندازی و استفاده از سیستمهای هوش مصنوعی مشارکت داشته باشند. همچنین، باید بخصوص به موقعیتهایی توجه کرد که در آن سیستمهای هوش مصنوعی میتوانند اثرات نامطلوبی را ایجاد یا تشدید کنند که ناشی از نامتقارنبودن قدرت یا اطلاعات است، مثلاً میان کارفرمایان و کارمندان، مشاغل و مصرفکنندگان یا دولتها و شهروندان. همچنین، پیشگیری از آسیب مستلزم توجه به محیط طبیعی و همهی موجودات زنده است.

.اصل انصاف

توسعه، راهاندازی و استفاده از سیستمهای هوش مصنوعی باید منصفانه باشد. در عینِ اینکه ما اذعان داریم تفاسیر مختلف زیادی از انصاف وجود دارد، ولی معتقدیم که انصافهم بُعد جوهری دارد و هم رویهای. بُعد جوهری به معنای تعهد به تضمینِ توزیع برابرانه و عادلانهی هم مزایا و هم هزینهها و تضمینِ این است افراد و گروهها عاری از تعصبِ نامنصفانه، تبعیض و بدنامسازی هستند. اگر بتوان از تعصبات نامنصفانه خودداری کرد، سیستمهای هوش مصنوعی حتی میتوانند میزان انصاف اجتماعی را بالا ببرند. فرصت برابر در شرایطِ دسترسی به آموزش، کالاها، خدمات و فناوری باید افزایش داد. علاوه براین، استفاده از سیستمهای هوش مصنوعی هرگز نباید منجر به فریب مردم شود یا به طرزی ناموجّه به آزادی انتخاب آنها آسیب بزند. بعلاوه، انصاف به این معناست که متخصصان هوش مصنوعی باید به اصل تناسب میان وسیلهها و اهداف احترام بگذارند و نحوهی ایجاد تعادل میان ابژهها و منافع رقیب را بهدقت بررسی کنند. بعد رویهایِ انصاف متضمن توانایی در رقابت است و بهدنبال راه چارهای مؤثر برای تصمیماتی است که سیستمهای هوش مصنوعی و انسانهایی میگیرند که آنها را اداره میکنند. برای انجام این کار، واحدِ مسئولِ تصمیمگیری باید قابلشناسایی باشد و فرآیندهای تصمیمگیری نیز باید توضیحپذیر باشند.

.اصل توضیحپذیری

توضیحپذیری برای ایجاد اعتماد میان کاربرانِ سیستمهای هوش مصنوعی بسیار مهم است. این بدان معناست که فرآیندها باید شفاف باشند، میان قابلیتها و اهداف سیستمهای هوش مصنوعی آشکارا ارتباط وجود داشته باشد و تصمیمات ـ تا حد امکان ـ برای افرادی که مستقیم یا غیرمستقیم تحتتأثیر این سیستمها هستند توضیحپذیر باشد. بدون چنین اطلاعاتیی، تصمیم چندان نمیتواند بحثبرانگیز باشد. توضیحِ این که چرا الگویی، برونداده یا تصمیم خاصی را به وجود آورده است (و اینکه چه ترکیبی از عوامل دروندادهای در آن سهیم بودهاند) همیشه امکانپذیر نیست. این نمونهها به الگوریتمهای «جعبهی سیاه» موسوم هستند و نیاز به توجه ویژهای دارند. در این شرایط، ممکن است سایر اقدامات توضیحپذیر (مانند قابلیتِ ردیابی، نظارتپذیری و ارتباطات شفاف دربارهی قابلیتهای سیستم) لازم باشد، مشروط به اینکه سیستم بهمثابهی یک کل به حقوق اساسی احترام بگذارد. این که تا چه حدی لازم است تکرارپذیری انجام شود، در صورتی که آن خروجی اشتباه یا، در غیر این صورت، نادرست باشد، تا اندازهی زیادی به بستر و دقتِ نتایج آن بستگی دارد.

۳ـ ۲ تنشهای موجود میان اصول

ممکن است میان اصول بالا تنشهایی به وجود آید که راهحل ثابتی برای آن نباشد. در راستای تعهد بنیادینِ اتحادیهی اروپا به مشارکتِ دموکراتیک، روند مناسب و مشارکت سیاسیِ همگانی برای مقابله با چنین تنشهایی روشهای موجّهی برای چارهجویی باید ایجاد شود. برای مثال، در حوزههای کاربردیِ متعدد، اصل جلوگیری از آسیب و اصل خودمختاری انسان چهبسا در تعارض باشند. مثلاً استفاده از سیستمهای هوش مصنوعی برای «اقدامات پلیسیِ پیشبینیکنندهی جرم» را در نظر بگیرید که ممکن است به کاهش جرایم کمک کند، اما به روشی که مستلزم فعالیتهای نظارتی است چهبسا به آزادی و حریم خصوصی افراد آسیب بزند. علاوه بر این، مزایای سیستمهای هوش مصنوعی رویهمرفته باید اساساً از خطرات فردی پیشبینیپذیر فراتر روند. در عین این که اصول بالا قطعاً راهنمای ما در یافتنِ راهحلها هستند، ولی همچنان نسخههای اخلاقیِ ناملموسی هستند. بنابراین، از متخصصان هوش مصنوعی نمیتوان انتظار داشت که بر اساس اصول بالا راهحل مناسبی را پیدا کنند، با این حال، رویکرد آنها به معاوضات و تنگناهای اخلاقی باید این باشد که از تأملات مستدل و مبتنی بر شواهد استفاده کنند.

با این حال، چهبسا شرایطی وجود داشته باشد که هیچگونه دادوستد اخلاقیِ قابلقبولی را نتوان شناسایی کرد. برخی از حقوق اساسی و اصول اخلاقی مطلق هستند و نمیتوانند به ممارستِ [اخلاقی] توازنبخش (مثلِ کرامت انسان) مشروط باشند.

راهنمای کلیدی برگرفته از فصل یکم:

۱. سیستمهای هوش مصنوعی را به روشی توسعه دهید، راه بیندازید و از آنها استفاده کنید که به اصول اخلاقیِ زیر پایبندباشد: احترام به خودمختاری انسان، جلوگیری از آسیب، انصاف و توضیحپذیری. شناسایی و بررسیِ تنشهای احتمالی میان اصول.

۲. بهویژه به موقعیتهایی توجه داشته باشید که در آن گروههای آسیبپذیرتر مانند کودکان، افراد معلول و سایر افرادی حضور دارند که در طول تاریخ در معرض محرومیت بودهاند یا در معرض محرومیت قرار دارند و همچنین به موقعیتهایی که مشخصهی آنها نبودِ تقارنِ قدرت یا اطلاعات است، مثلاً میان کارفرمایان و کارگران، یا میان مشاغل و مصرفکنندگان.

۳. بپذیرید با وجود اینکه سیستمهای هوش مصنوعی مزایای بسیاراساسی را برای افراد و جامعه به ارمغان میآورد خطراتی هم دارند و ممکن است تأثیرات منفی داشته باشند، از جمله تأثیراتی که ممکن است پیشبینی، شناسایی یا اندازهگیری آن دشوار باشد (مثلاً تأثیر بر دموکراسی، حاکمیت قانون و عدالت توزیعی یا تأثیر بر ذهن خودِ انسان). در صورت لزوم و به تناسبِ میزان خطر انتخاب تدابیر مناسب برای کاهش این خطرات [ضروری است].

فصل دوم: تحقق هوش مصنوعی اطمینانبخش

این فصل براساس اصول مطرح در فصل اول و با فهرستبندی ۷ شرطی که باید رعایت شوند برای اجرا و تحقق هوش مصنوعی اطمینانبخش راهنمایی را ارائه میدهد. علاوه براین، برای عملیاتیکردن این شروط در طول چرخهی حیات سیستم هوش مصنوعی روشهای فنی و غیرفنیِ موجود معرفی شدهاند.

۱.شروط هوش مصنوعی اطمینانبخش

برای دستیابی به هوش مصنوعی اطمینانبخش، اصول مطرح در فصل اول باید به صورت شروطی ملموس ترجمه شوند. این شروط برای صاحبان منافع مختلفی کاربردپذیر است که در چرخهی حیات سیستمهای هوش مصنوعی مشارکت دارند: توسعهدهندگان، راهاندازان و کاربران نهایی، همچنین جامعهی گستردهتر. منظور ما از توسعهدهندگان استناد به کسانی است که دربارهی سیستمهای هوش مصنوعی تحقیق میکنند، طراحی میکنند و/یا آنها را توسعه میدهند. همچنین منظور ما استناد به سازمانهای دولتی یا خصوصی است که در فرآیندهای تجاری خود و ارائهی فرآوردهها و خدمات به دیگران از سیستمهای هوش مصنوعی استفاده میکنند. کاربران نهایی آنهایی هستند که مستقیم یا غیرمستقیم با سیستمهای هوش مصنوعی سروکار دارند. درنهایت، جامعهی گستردهتر شامل تمام افراد دیگری میشود که مستقیم یا غیرمستقیم تحت تأثیر سیستمهای هوش مصنوعی قرار دارد.

گروههای مختلفی از صاحبان منافع نقشهای متفاوتی در تضمین رعایتِ این شروط دارند:

۱.توسعهدهندگان باید این شروط را برای طراحی و توسعهی فرآیندها اجرا و به کار گیرند.

۲.توسعهدهندگان باید تضمین دهند در این سیستمهایی که آنها استفاده میکنند و فرآوردهها و خدماتی که ارائه میدهند این شروط رعایت میشود.

۳.کاربران نهایی و جامعهی گستردهتر باید از این شروط مطلع شوند و بتوانند درخواستِ اِعمالشدن آنها را داشته باشند.

فهرست شروط زیر جامع نیست. این فهرست دارای ابعاد نظاممند، فردی و اجتماعی است:

۱.عاملیت و نظارت انسانی

از جمله حقوق اساسی، عاملیت و نظارت انسانی.

۲.استحکام فنی و ایمنی

از جمله تابآوری دربرابر حمله و امنیتداشتن، برنامهی بدیل و امنیت عمومی، دقت، قابلاعتمادبودن و تکرارپذیری.

۳.حریم خصوصی و سازماندهی داده

از جمله احترام به حریم خصوصی، کیفیت و یکپارچگی داده و دسترسی به داده

۴.شفافیت

از جمله قابلیت ردیابی، توضیحپذیری و تبادل اطلاعات

۵.تنوع، نبود تبعیض و انصافداشتن

از جمله اجتناب از سوگیریهای نامنصفانه، قابلیت دسترسی و طراحی جهانی و مشارکت صاحبان منافع.

۶.رفاه اجتماعی و محیطی

از جمله قابلیت پایداری و سازگاری با محیط زیست، تأثیر اجتماعی، جامعه و دموکراسی.

۷.پاسخگویی

از جمله قابلیتِ بازرسی، به کمینهرساندن و گزارش اثرات منفی، معاوضهی ملاحظهکارانه و جبران خسارت.

در حالی که تمام شروط اهمیت یکسانی دارند، هنگام اِعمال آنها در حوزهها و صنایع مختلف باید بستر و تنشهای بالقوه میان آنها را در نظر گرفت. اجرای این شروط باید در سرتاسر طول چرخهی حیات سیستم هوش مصنوعی اتفاق بیفتد و به کاربرد خاص آن وابسته باشد. در حالی که بیشتر شروط برای تمام سیستمهای هوش مصنوعی اِعمال میشود، توجه ویژه به مواردی لازم است که مستقیم یا غیرمستقیم بر افراد تأثیر دارند. بنابراین، در برخی از برنامههای کاربردی (برای مثال، تنظیمات پایه و صنعت) آنها ممکن است از اهمیت کمتری برخوردار باشند. شروطی که بالا بیان شد مؤلفههایی دارد که در برخی موارد از قبل در قوانین موجود انعکاس یافته است. ما بازهم تأکید میکنیم که ــ مطابق با اولین مؤلفه از هوش مصنوعی اطمینانبخش ــ این مسئولیتِ متخصصانِ هوش مصنوعی است که از رعایت تکالیف قانونیِ خود اطمینان حاصل کنند، هم دربارهی قوانین کاربردپذیرِهمترازانه و هم مقررات مربوط به دامنه.

در پاراگرافهای زیر، هر یک از شروط مفصلاً توضیح داده شده است.

۱ ـ ۱ عاملیت و نظارت انسانی

همانطور که در اصل احترام به استقلال انسان تجویز شده است، سیستمهای هوش مصنوعی باید پشتیبانِ خودمختاری و تصمیمگیری انسان باشند. این امر مستلزم آن است که سیستمهای هوش مصنوعی با پشتیبانی ازعاملیتِ کاربر هم عاملانی توانمندساز برای جامعهی دموکراتیک، پیشرفتکننده و دادورانه باشند و هم حقوق اساسی را بپرورانند و نظارت انسانی را درنظر بگیرند.

حقوق اساسی

سیستمهای هوش مصنوعی میتوانند همانند بسیاری از فناوریها حقوق اساسی را میسر کنند یا مانع از آن شوند. برای مثال آنها میتوانند با کمک به مردم در ردیابیِ دادههای شخصیشان یا با افزایش دسترسی به آموزش و درنتیجه حمایت از حقشان برای آموزش، به آنها سود برسانند. با این حال، با توجه به دسترسی و ظرفیتِ سیستمهای هوش مصنوعی آنها میتوانند بر حقوق اساسی نیز تأثیر منفی بگذارند. در مواقعی که چنین خطراتی وجود دارد، ارزیابی تأثیر حقوق اساسی هم باید انجام شود. این باید مقدم بر توسعهی سیستم انجام شود و این امر را هم ارزیابی کرد که آیا بهمنظور احترام به حقوق و آزادی دیگران میتوان آن خطرات را به کمترین حد رساند یا آن را به عنوان امری ضروری در جامعهی دموکراتیک توجیه کرد. علاوه بر این، برای دریافت بازخوردهای خارجی دربارهی سیستمهای هوش مصنوعی که مستعدِ نقض حقوق اساسی هستند باید سازوکارهایی را ایجاد کرد.

عاملیت انسانی

کاربران باید بتوانند دربارهی سیستمهای هوش مصنوعی آگاهانه تصمیمگیری کنند. دانش و ابزارهایی برای درک و تعامل با سیستمهای هوش مصنوعی باید در حد رضایت در اختیار کاربران قرار بگیرد و در صورت امکان کاربران بتوانند ارزیابی عقلانی از سیستم هوش مصنوعی داشته باشند یا آن را به چالش بکشانند. سیستمهای هوش مصنوعی باید افراد را مطابق با اهدافی که دارند در انتخابهای بهتر و آگاهانهتر یاری کنند. سیستمهای هوش مصنوعی گاهی میتوانند از طریق سازوکارهایی که تشخیص آنها چهبسا دشوار است در شکلدهی و تأثیرگذاری بر رفتار انسان به کار گرفته شوند، زیرا این سیستمها ممکن است فرآیندهای ناخودآگاه را به اَشکال متعددی در کنترل خود درآورند، مثلاً با بازیچهقراردادنِ نامنصفانه، فریب، گلهای و شرطی کردن افراد؛ همگی اینها میتوانند خودمختاری انسان را تهدید کنند. اصلِ کلی خودمختاریِ کاربر برای کارآمدیِ سیستم باید امری اساسی باشد. کلیدِ این موضوع این است که وقتی این سیستم اثرات قانونی را برای کاربران به بار میآورد یا به نحو مشابه شدیداً بر آنها تأثیرمیگذارد، رویکرد صحیح تنها متأثر از تصمیمگیری براساس فرآیند خودمختارانه نباشد.

نظارت انسانی: نظارت انسانی به تضمینِ این امر کمک میکند که سیستم هوش مصنوعی خودمختاری انسان را تضعیف نمیکند یا باعث ایجاد اثرات نامطلوب دیگری نمیشود. نظارت ممکن است از طریق سازماندهی سازوکارهایی مانند human-in-the- loop (HITL), human-on-the-loop (HOTL) یا رویکرد human-in-command (HIC) انجام شود. HITL به ظرفیت مداخلهی انسانی در تمام تصمیمات چرخهی سیستم هوش مصنوعی اشاره دارد که در بسیاری از موارد نه ممکن است و نه مطلوب. HTOL به ظرفیت مداخلهی انسانی در طول طراحی چرخهی سیستم هوش مصنوعی و نظارت بر عملکرد آن اشاره دارد. HIC به ظرفیت نظارت بر فعالیت کلیِ سیستم هوش مصنوعی (از جمله تأثیرات اقتصادی، اجتماعی، قانونی و اخلاقی وسیع آن) و توانایی تصمیمگیری دربارهی زمان و چگونگی استفاده از سیستم در هر موقعیت خاص اشاره دارد. این ظرفیت ممکن است تصمیم به استفادهنکردن از سیستم هوش مصنوعی در موقعیتی خاص، تعیین سطوح اختیارات انسانی هنگام استفاده از سیستم، یا تضمینِ توانایی انسان برای لغو تصمیمگیریِ سیستم باشد. علاوه بر این، باید تضمین شود که اجراکنندههای عمومی توانایی اِعمال نظارت در راستای اختیارات خود را دارند. بسته به حوزههای کاربردی و خطرات بالقوهی سیستم، برای تأمین امنیت و کنترل مقیاسها از جهات مختلف به سازوکارهای بازنگری و نظارت نیاز است. با وجود برابربودن سایر چیزهای دیگر، هر چه نظارت انسان بر سیستم هوش مصنوعی کمتر باشد، به آزمایش بیشتر و سازماندهی سختگیرانهتری نیاز است.

۲ ـ ۱ استحکام فنی و ایمنی

یکی از مؤلفههای حیاتی در دستیابی به هوش مصنوعی اطمینانبخش استحکام فنی آن است که ارتباط نزدیکی با اصل جلوگیری از آسیب دارد. استحکام فنی مستلزم آن است که سیستمهای هوش مصنوعی با رویکرد پیشگیرانه به خطرات توسعه یابند تا همان طور که قبلاً درنظر گرفته شده است به طریقی قابلاعتماد رفتار کنند و در عین حال آسیبهای ناخواسته و غیرمنتظره را به حداقل برسانند و از آسیبهای غیرقابلقبول جلوگیری کنند. این مؤلفه باید دربارهی تغییرات بالقوه در محیط عملیاتی سیستمها یا حضورعاملان دیگر(انسانی و مصنوعی) نیز اِعمال شود که ممکن است به طریقی دشمنانه با سیستم هوش مصنوعی تعامل داشته باشند. علاوه براین، یکپارچگی جسمانی و ذهنی انسانها باید تضمین شود.

مقاومت در برابر حمله و امنیت: سیستمهای هوش مصنوعی، مانند سیستمهای سختافزاری، باید در برابر آسیبهایی مانند هککردن محافظت شوند که ممکن است آنها را در معرض سوءاستفادهی دشمنان قرار دهد. حملات ممکن است داده (مسمومیت داده)، الگو (فاششدن الگو) یا شالودههای زیربنایی، هم نرمافزاری و هم سختافزاری را هدف قرار دهند. اگر سیستم هوش مصنوعی موردحمله قرار بگیرد، برای مثال در حملات دشمنانه، دادهها و همچنین رفتار سیستم را میتوان تغییر داد، سیستم را به تصمیمات متفاوتی سوق داد یا کلاً آن را خاموش کرد. همچنین ممکن است سیستمها و دادهها در اثر بدخواهی یا قرارگرفتن در معرض موقعیتهای غیرمنتظره خراب شوند. فرآیندهای امنیتی ناکافی نیز ممکن است به تصمیمات اشتباه یا حتی آسیب جسمانی منجر شود. برای اینکه سیستمهای هوش مصنوعی ایمن تلقی شوند برنامههای کاربردیِ احتمالاً ناخواستهی سیستم هوش مصنوعی (مانند برنامههای کاربردی دوگانه) وسوءاستفادهی فعالانِ بدخواه احتمالی از سیستم باید درنظر گرفته شوند و اقدامات لازم برای جلوگیری و کاهش آنها انجام شود.

برنامهی بدیل و ایمنی عمومی: سیستمهای هوش مصنوعی باید محافظهایی داشته باشند که در صورت بروز مشکل برنامهی بدیلی را فعال سازد. چنین چیزی میتواند به این معنا باشد که سیستمهای هوش مصنوعی از رویهی آماری به رویهی قانونمحور تغییر کنند یا اینکه قبل از ادامهی فعالیت خود از اپراتور انسانی اجازه بگیرند. باید اطمینان حاصل شود که سیستم هوش مصنوعی آن چیزی را انجام میدهد که قرار است انجام دهد بدون اینکه به موجودات زنده یا محیط زیست آسیب برساند. این اطمینانیابی یعنی به کمترین میزان رساندنِ عواقب و خطاهای ناخواسته است. علاوه بر این، برای شفافسازی و ارزیابیِ خطرات بالقوهی مرتبط با استفاده از سیستمهای هوش مصنوعی، در حوزههای کاربردی نیز باید فرآیندهایی ایجاد شود. سطح ایمنیِ مقیاسهای موردنیاز به میزان خطراتی بستگی دارد که سیستم هوش مصنوعی به همراه دارد که بهنوبهی خود به ظرفیتهای سیستم بستگی دارد. در مواردی که میتوان پیشبینی کرد فرآیند توسعه یا خودِ سیستم خطرات زیادی را به همراه دارد، بسیار حیاتی است که مقیاسهای ایمنی فعالانه توسعه یابند و آزمایش شوند.

دقت: دقت به توانایی سیستم هوش مصنوعی در داوریکردنِ صحیح، برای مثال، طبقهبندی صحیحِ اطلاعات در گروههای مناسب یا توانایی سیستم در درست پیشبینیکردن، توصیهها، یا تصمیماتی مربوط میشود که مبتنی بر داده یا الگوها هستند. فرآیند توسعه و ارزیابیِ صریح که به شکل مناسبی شکل گرفته است میتواند خطرات ناخواستهی ناشی از پیشبینیهای نادقیق را تأیید کرده، آنها را تصحیح کند و کاهش دهد. زمانی که نتوان از پیشبینیهای نادقیق خودداری کرد، مهم است که سیستم هوش مصنوعی بتواند میزان احتمال این خطاها را بیان کند. بخصوص در موقعیتهایی که سیستم هوش مصنوعی مستقیماً بر زندگی انسان تأثیر میگذارد میزان زیادی از دقت ضروری است.

اعتبار و تکرارپذیری: بسیار مهم است که نتایج سیستمهای هوش مصنوعی تکرارپذیر و نیز معتبر باشند. سیستم هوش مصنوعی معتبر سیستمی است که با طیفی از ورودیها و در طیفی از موقعیتها بهدرستی کار میکند. چنین چیزی برای بازرسیِ دقیق سیستم هوش مصنوعی و جلوگیری از آسیبهای ناخواسته لازم است. تکرارپذیری توصیف این پرسش است که آیا آزمایشکردنِ هوش مصنوعی در شرایط مشابه، رفتار یکسانی را نشان میدهد یا خیر. این امر به دانشمندان و سیاستگذاران این امکان را میدهد تا آنچه را که سیستمهای هوش مصنوعی انجام میدهند با دقت توصیف کنند. تکرار فرمانها میتواند فرآیند آزمایش و بازتولید رفتارهای سیستم را تسهیل کنند.

۳ ـ ۱ حریم خصوصی و سازماندهی داده

حریم خصوصی ارتباط نزدیکی با اصلِ جلوگیری از آسیب دارد؛ حریم خصوصی حقی اساسی است که بخصوص از سیستمهای هوش مصنوعی تأثیر میپذیرد. جلوگیری از آسیب به حریم خصوصی مستلزم آن است که دادههای کافی بر سیستم حاکم باشند تا کیفیت و یکپارچگیِ دادههای مورداستفاده، ارتباط آن با حوزهای که سیستمهای هوش مصنوعی در آن اجرا میشوند، پروتکلهای دسترسی و ظرفیت آن را پوشش دهد.

حریم خصوصی و حفاظت از داده: سیستمهای هوش مصنوعی باید حریم خصوصی و حفاظت از دادهها را در طول چرخهی حیاتِ تمام سیستم تضمین کنند. این امر هم شامل اطلاعاتی است که کاربر ارائه میدهد و هم اطلاعاتی که در طول تعامل با سیستم دربارهی کاربر به وجود آمده است (برای مثال، خروجیهایی که سیستم هوش مصنوعی برای کاربران خاص ایجاد کرده یا نحوهی پاسخِ کاربران به توصیههای خاص). سوابق دیجیتالی رفتار انسان ممکن است برای سیستمهای هوش مصنوعی این امکان را فراهم کند که نهتنها پسندهای افراد، بلکه به گرایشات جنسی، سن، جنیست، دیدگاههای مذهبی یا سیاسی آنها نیز اشاره کند. برای اینکه افراد بتوانند به فرآیند گردآوری دادهها اعتماد کنند، باید اطمینان حاصل شود که دادههای گردآوریشده دربارهی آنها در تبعیضگذاردنِ غیرقانونی یا نامنصفانه علیه آنها به کار نرفته است.

کیفیت و یکپارچگیِ دادهها: کیفیت مجموعهی دادههای مورداستفاده در عملکرد سیستمهای هوش مصنوعی بسیار مهم است. زمانی که دادهها گردآوری میشوند، ممکن است حاوی سوگیریهای برخاسته از اجتماع، نادرستیها، خطاها و اشتباهات باشند. لازم است قبل از آموزش با هر مجموعه دادهای این موارد بررسی شود. علاوه بر این، باید از یکپارچگی دادهها اطمینان حاصل شود. واردکردنِ دادههای مخرّب به سیستم هوش مصنوعی چهبسا رفتار آن را تغییر دهد، بهویژه در ارتباط با سیستمهای خودآموز. فرآیندها و مجموعه دادههای مورد استفاده باید در هر مرحله مانند برنامهریزی، آموزش، آزمایش و راهاندازی باید آزمایش شده و ثبت شوند. همچنین، این امر باید دربارهی سیستمهای هوش مصنوعی نیز اِعمال شود که در داخل سازمان توسعه نیافتهاند، بلکه جای دیگری بدست آمدهاند.

دسترسی به دادهها: در هر سازمان مشخصی که دادههای افراد را مدیریت میکنند (خواه کسی کاربر سیستم باشد یا نباشد)، پروتکلهای دادهای اجرا شوند که بر دسترسی به داده نظارت دارند. این پروتکلها باید مشخص کنند که چه کسانی میتوانند به دادهها و در هر شرایطی دسترسی داشته باشند. فقط پرسنل واجدِ شرایط و صلاحیت ونیازمند به دسترسی به دادههای افراد باید مجاز به انجام این کار باشند.

۴ ـ ۱ شفافیت

این شرط با اصلِ توضیحپذیری ارتباط نزدیکی دارد و به معنای شفافیتِ مؤلفههای مرتبط با سیستم هوش مصنوعی است؛ از جمله داده، سیستم و الگوهای تجاری.

قابلیت ردیابی: مجموعه دادهها و فرآیندهایی که تصمیم هوش مصنوعی را با خود همراه دارد، با توجه به گردآوری و برچسبگذاریِ دادهها و همچنین الگوریتمهای مورداستفاده باید با بهترین استاندارد ممکن ثبت شوند تا قابلیت ردیابی و شفافیت را فراهم سازند. همچنین، این شرط به تصمیماتی اطلاق میشود که سیستم هوش مصنوعی میگیرد. این شرط امکان شناسایی دلایلِ تصمیمات اشتباه سیستم هوش مصنوعی را فراهم میکند و بهنوبهی خود میتواند به جلوگیری از اشتباهات آینده کمک کند. قابلیت ردیابی،قابلیتِ بازرسی و نیز توضیحپذیری را تسهیل میکند.

توضیحپذیری: توضیحپذیری به توانایی توضیحِ فرآیندهای فنیِ سیستم هوش مصنوعی و تصمیماتِ انسانی(مثلاً قلمروهای کاربردِ این سیستم) مرتبط میشود. توضیحپذیری مستلزم آن است که انسانها بتوانند متوجه تصمیماتی شوند که هوش مصنوعی میگیرد و آن را ردیابی کنند. علاوه بر این، ممکن است میان افزایش توضیحپذیری سیستم (که ممکن است دقت آن را کاهش دهد) یا افزایش دقت آن (در ازای توضیحپذیری) معاوضهای ملاحظهکارانه صورت بگیرد. هر زمان سیستم هوش مصنوعی تأثیر قابلتوجهی بر زندگی افراد داشته باشد باید این امکان وجود داشته باشد که بتوان دربارهی فرآیند تصمیمگیریِ سیستم هوش مصنوعی توضیح مناسبی را مطالبه کرد. چنین توضیحی باید بهموقع باشد و با تخصصِ صاحبان منافع مربوطه (مثلاً فرد عادی، سامانگرِ سیستم و پژوهشگر) سازگار باشد. علاوه بر این، توضیحات مربوط به میزان تأثیرِ سیستم هوش مصنوعی بر فرآیند تصمیمگیریِ سازمانی، طراحی انتخابهای سیستم و دلیل اصلیِ راهاندازی آن باید در دسترس باشد (درنتیجه، شفافیت مدل تجاری را تضمین کند).

ابلاغ: سیستمهای هوش مصنوعی نباید نزد کاربران وانمود کنند که انسان هستند. انسانها حق دارند که بدانند با هوش مصنوعی در تعاملاند. این امر مستلزم آن است که سیستمهای هوش مصنوعی حتماً بهخودیِخود شناساییپذیر باشند. علاوه بر این، درصورت لزوم و برای تضمینِ رعایتِ حقوق اساسی، گزینهی منصرفشدن از این تعامل با هوش مصنوعی و تمایل به تعامل انسانی باید فراهم باشد. فراتر از این، قابلیتها و محدودیتهای سیستم هوش مصنوعی باید به روشی متناسب با کاربردِ نمونهی موردنظر به متخصصان یا کاربران نهایی ابلاغ شود. این امر شامل ابلاغِ میزان دقت سیستم هوش مصنوعی و نیز محدودیتهای آن میشود.

۵ ـ ۱ تنوع، نبودِ تبعیض و انصافداشتن

برای دستیابی به هوش مصنوعی اطمینانبخش باید فراگیربودن و تنوع را در سرتاسر چرخهی حیات سیستم هوش مصنوعی فعال کنیم. علاوه بر درنظرگرفتن و مشارکتکردنِ تمام صاحبانِ منافع در طول فرآیند این امر متضمنِ اطمینانیافتن به دسترسیِ برابر از طریق فرآیندهای طراحیِ فراگیر و همچنین رفتارِ برابر است. این شرط ارتباط نزدیکی با اصلِ انصاف دارد.

پرهیز از سوگیری نامنصفانه: مجموعه دادههایی که سیستمهای هوش مصنوعی (هم برای آموزش و هم در عملکرد) به کار میبرند چهبسا ازفراگیربودنِ سوگیری تاریخی غیرعمدیِ، ناقصبودن و حاکمیت الگوهای بد رنج ببرند. تداوم چنین سوگیریهایی میتواند به تعصبِ ناخواستهی (غیر)مستقیم و تبعیض علیه گروهها یا افراد خاص، تعصبات مستعدِ تشدید و طردشدن منجر شود. این آسیب همچنین میتواند در نتیجهی بهرهبرداریِ عمدی از سوگیریهای (مصرفکننده) یا با درگیرشدن در رقابتی نامنصفانه مانند ناهمگنسازی قیمتها از طریق زدوبند یا بازاری ناشفاف به وجود آید. سوگیری شناساییپذیر و تبعیضآمیز باید در صورت امکان در مرحلهی گردآوری حذف شود. روشی که در آن سیستمهای هوش مصنوعی توسعه مییابند (مثلاً برنامهنویسی الگوریتمها) ممکن است از سوگیریِ ناعادلانه رنج ببرند. میتوان با قراردادنِ فرآیندهای نظارتی برای تحلیل و بررسی اهداف، موانع، شروط و تصمیمات سیستم به طریقی شفاف و آشکار با این سوگیریها مقابله کرد. علاوه بر این، استخدام از طبقات، فرهنگها وپیروان مختلف میتواند تنوع نظرات را تضمین کند و این کار را باید تشویق کرد.

دسترسیپذیری و طراحی جهانی

سیستمهای هوش مصنوعی بخصوص در حوزههای تجارت ـ با ـ مصرفکننده باید کاربرمحور باشند و به طریقی طراحی شوند که تمام افراد، صرفنظر از سن، جنسیت، تواناییها یا ویژگیهایشان، امکان استفاده از محصولات یا خدمات هوش مصنوعی را داشته باشند. دسترسی به این فناوری برای افراد دارایِ معلولیت که در تمام گروههای اجتماعی حضور دارند از اهمیت ویژهای برخوردار است. سیستمهای هوش مصنوعی نباید رویکردی همهمنظوره داشته باشند و باید اصول طراحی جهانی را، به تبعِ استانداردهای دسترسیپذیری مربوط، درنظر بگیرند که مخاطبان آن گستردهترین طیفهای ممکن از کاربران هستند.این شرط امکان دسترسی عادلانه و مشارکت فعالِ تمام افراد را در فعالیتهای انسانی موجود و نوظهورِ رایانهمحور و در ارتباط با فناوریهای کمکی میسر میسازد.

مشارکت صاحبان منافع: توصیه میشود بهمنظور توسعهی سیستمهای هوش مصنوعی که اطمینانبخش باشند با صاحبان منافعی مشورت کنید که احتمالاً مستقیم یا غیرمستقیم درسراسر چرخهی حیات سیستم متأثر از آن هستند. درخواستِ ارائهی بازخورد منظم حتی پس از راهاندازی و راهاندازیِ سازوکارهای بلندمدت، برای مثال تضمینِ اطلاعاتِ کارکنان، مشورت و مشارکت در تمام طول فرآیند اجرای سیستمهای هوش مصنوعی در سازمانها، برای مشارکت صاحبان منافع سودمند است.

۶ ـ ۱ رفاه محیطی و اجتماعی

در راستای رعایت اصولِ انصاف و جلوگیری از آسیب، جامعهی وسیعتر، سایر موجودات شعورمند و محیط نیز در سراسر چرخهی حیات سیستم هوش مصنوعی باید صاحبان منافع در نظر گرفته شوند. باید افراد را به پایداریِ منابع طبیعی و مسئولیتِ زیستمحیطی در برابر سیستمهای هوش مصنوعی تشویق کرد و تحقیقاتِ مربوط به راهحلهای هوش مصنوعی در زمینهی دغدغههای جهانی مانند اهداف توسعهی پایدار بدون کاهش در منابع طبیعی افزایش یابد. در حالت آرمانی، سیستمهای هوش مصنوعی باید در جهت منافع تمام انسانها و از جمله نسلهای آینده استفاده شوند.

هوش مصنوعی پایدار و سازگار با محیط زیست: سیستمهای هوش مصنوعی وعده میدهند که به رفعِ برخی از مهمترین دغدغههای جامعه را کمک کنند، اما باید تضمین شود که به بهترین روش دوستانهی ممکن با محیط زیست صورت میگیرد. توسعهی سیستم، راهاندازی و استفاده از سیستم و همچنین کل زنجیرهی آمایش آن باید در این رابطه ارزیابی شود؛ برای مثال از طریق بررسی انتقادیِ مصرفِ منابع و انرژی در طول آموزش و انتخاب گزینههای کمضررتر. برای تضمینِ سازگاریِ کلِ زنجیرهی آمایش سیستم هوش مصنوعی با محیط زیست اقداماتی باید صورت گیرد.

تأثیر اجتماعی: اینکه درهر حوزهای در معرضِ سیستمهای اجتماعیِ هوش مصنوعی قراربگیریم (خواه در آموزش، کار، خدمات درمانی و سرگرمی) ممکن است تصور ما از عاملیت اجتماعی را تغییر دهد یا بر روابط اجتماعی و دلبستگیِ ما تأثیر بگذارد. در حالی که سیستمهای هوش مصنوعی میتوانند برای افزایش مهارتهای اجتماعیِ به کار روند، به همان اندازه میتوانند به زوال آنها کمک کنند. این امر همچنین میتواند بر جسم و روان افراد تأثیر بگذارد. بنابراین، اثرات این سیستمها باید بهدقت بررسی و بر آنها نظارت شود.

جامعه و دموکراسی: فراتر از ارزیابی اثراتِ توسعه، راهاندازی و استفاده از سیستم هوش مصنوعی بر افراد، این تأثیرات باید از منظر اجتماعی نیز ارزیابی شود و تأثیرآنها بر نهادها، دموکراسی و عمومِ جامعه در نظر گرفته شود. دراستفاده از سیستمهای هوش مصنوعی بهویژه در موقعیتهای مربوط به فرآیند دموکراتیک، نهفقط در تصمیمگیریهای سیاسی، بلکه در زمینههای انتخاباتی نیز باید دقت شود.

۷ ـ ۱ پاسخگویی

شرط پاسخگویی مکمل شروط بالاست و ارتباط نزدیکی با اصل انصاف دارد. این امر مستلزم آن است که سازوکارهایی برای تضمینِ مسئولیت و پاسخگوییِ سیستمهای هوش مصنوعی و نتایج آن، هم قبل از توسعه و هم پس از توسعه، راهاندازی و استفاده از آنها در نظر گرفته شود.

قابلیتِ بازرسی:قابلیتِ بازرسی مستلزم امکان ارزیابی الگوریتمها، دادهها و فرآیندهای طراحی است. این لزوماً به این معنا نیست که اطلاعات مربوط به الگوهای تجاری و مالکیتِ معنوی مرتبط با هوش مصنوعی بایستی همیشه و آشکارا در دسترس باشد. ارزیابی از طریق ممیزهای خارجی و در دسترسبودنِ این گزارشات ارزیابی میتواند بر اطمینانبخشی فناوری اثر داشته باشد. در برنامههایی که بر حقوق اساسی تأثیر میگذارند از جمله برنامههای کاربردیِ حیاتی ایمنی، سیستمهای هوش مصنوعی باید بتوانند مستقلاً بازرسی شوند.

گزارشِ اثرات منفی و به کمترین حد رساندنِ آن: هم تواناییِ گزارشدادنِِ کارها یا تصمیماتی که بر بازدهیِ سیستمی خاص تأثیر دارند و هم واکنش به پیآمدهایِ چنین بازدهای باید تضمین شود. شناسایی، ارزیابی، ثبت مستندات و به کمترین حد رساندنِ اثرات منفیِ احتمالی سیستمهای هوش مصنوعی بخصوص برای کسانی بسیار مهم است که (غیر)مستقیم تحت تأثیر آن قرار گرفتهاند. وقتی از اختلالاتِ سیستم هوش مصنوعی گزارش صحیح میدهند باید از کسانی که کارهای غیرقانونی را افشا میکنند،سازمانهای مردمنهاد، اتحادیههای صنفی یا سایر نهادها به حدِ کافی حفاظت شود. استفاده از ارزیابیهای مربوط به تأثیرات منفی (برای مثال تیمسازی قرمز یا اَشکال ارزیابی تأثیرات الگوریتمی) چه قبل و چه هنگامِ توسعه، راهاندازی و استفاده از سیستمهای هوش مصنوعی میتواند برای کمترکردنِ تأثیرات منفی مفید باشد. این ارزیابیها باید با خطراتی که سیستمهای هوش مصنوعی به بار میآورند متناسب باشند.

معاوضات: هنگام اجرای شرایط بالا چهبسا تنشهایِ میان آنها افزایش یابد که خود به معاوضاتی اجتنابناپذیر بیانجامد. چنین معاوضاتی باید به طریقی روشمند و منطقی مطابق با آخرین پیشرفتهای علمی بررسی شوند. این امر مستلزم آن است که علایق و ارزشهای مرتبط با سیستم هوش مصنوعی شناسایی شوند و در صورت بروزِ تعارض باید صریحاً با معاوضات موافقت کرد و دربارهی خطرات آنها برای اصول اخلاقی از جمله حقوق اساسی ارزیابی صورت گیرد. در شرایطی که نتوان هیچ گونه معاوضاتِ اخلاقیِ قابلقبولی را شناسایی کرد توسعه، راهاندازی و استفاده از سیستم هوش مصنوعی نباید به آن شکل پیش رود. هر تصمیمی که دربارهی معاوضه گرفته میشود باید مستدل باشد و به شکل مناسب ثبت شود. تصمیمگیرنده باید در برابر روشی که معاوضهی مناسب بر اساس آن صورت میگیرد پاسخگوباشد، و باید به بازبینیِ مناسببودنِ تصمیمِ حاصل ادامه دهد تا تضمین کند که میتوان در صورتِ نیاز تغییرات لازم را در سیستم ایجاد کرد.

جبران خسارت: هنگامی که تأثیر مضرِّ ناعادلانه رخ میدهد، سازوکارهای دسترسپذیری باید برای این مواقع پیشبینی شود که تضمین کنند خسارتها به اندازهی کافی جبران میشود. با آگاهی از اینکه هنگامِ خرابشدنِ همه چیز جبرانِ خسارت امکانپذیر است کلیدِ تضمینِ اطمینان [به سیستم هوش مصنوعی] است. باید به افراد یا گروههای آسیبپذیر توجه ویژهای شود.

۲. روشهای فنی و غیرفنی برای تحققِ هوش مصنوعیِ اطمینانبخش

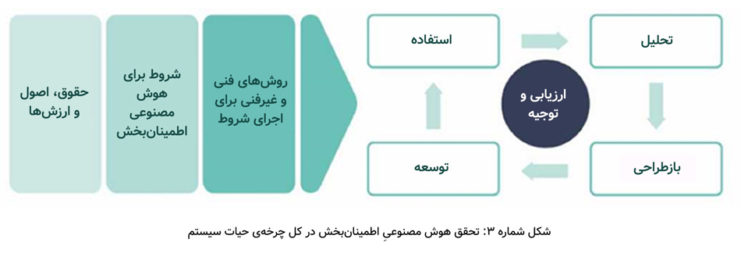

برای اجرای شروط بالا هم روشهای فنی و هم غیرفنی را میتوان به کار گرفت. این روشها تمام مراحل چرخهی حیات سیستم هوش مصنوعی را به کار میرود. ارزیابی روشهای بهکاررفته در اجرای شروط و همچنین گزارش و توجیه تغییرات برای اجرای فرآیندها باید پیوسته انجام شود. سیستمهای هوش مصنوعی همواره در حال تحول و پیشرفت هستند و در محیطی پویا کار میکنند. بنابراین، تحقق هوش مصنوعی اطمینانبخش فرآیندی پیوسته است، همانطور که اینجا در شکل ۳ نشان داده شده است.

روشهای زیر میتوانند مکمل یا بدیل یکدیگر باشند، زیرا شروط مختلف ــ و میزان حساسیتهای متفاوت ــ ممکن است نیاز به روشهای متفاوت اجرایی را افزایش دهد. این بررسی اجمالیِ نه جامع است و نه اجباری. در عوض، هدف آن ارائهی فهرستی از روشهای پیشنهادی است که ممکن است به اجرای هوش مصنوعی اطمینانبخش کمک کند.

۱ـ۲ روشهای فنی

این بخش روشهای فنیای را برای تضمینِ هوش مصنوعی اطمینانبخش توصیف میکند که میتواند در مراحل طراحی، توسعه و استفاده از فازهای سیستم هوش مصنوعی قرار بگیرد. روشهای تعیینشده در زیر در مراحل پیشرفت متفاوت هستند.

مهندسیِ هوش مصنوعی اطمینانبخش

شروط لازم برای هوش مصنوعی اطمینانبخش باید به شیوهها و/یا موانعِ موجود بر سر راه شیوههایی «تبدیل شوند» که لازم است در مهندسیِ سیستم هوش مصنوعی تثبیت شوند. این کار را میتوان از طریق راههای زیر تکمیل کرد: ۱٫ تنظیمِ قوانینی در «فهرست سفید» (رفتارها یا حالات) که سیستم همواره باید از آنها تبعیت کند، ۲٫ تنظیم «فهرست سیاه» دربارهی محدودیتهای مربوط به رفتارها یا حالاتی که سیستم هرگز نباید از آنها تخطی کند و۳٫ ترکیبی از آن قوانین یا تضمینهای اثباتپذیرِ پیچیدهتر در رابطه با رفتار سیستم. نظارت بر پیرویِ پایبندیسیستم به این محدودیتها در طول عملیات، چهبسا در فرآیندی جداگانه انجام شود.

میتوان سیستمهای هوش مصنوعی با قابلیتهای یادگیری را که قادرند رفتارهای خود را با فعالانه تعدیل کنند به شکل سیستمهایی درک کرد که قطعیت ندارند و احتمال دارد رفتار غیرمنتظرهای از خود نشان دهند. اینها اغلب از دریچهی نظریِ چرخهی «حس ـ برنامه ـ عمل» بررسی میشوند. پایبندی به تضمینِ هوش مصنوعی اطمینانبخش در مرحلهی مهندسیِ آن مستلزمِ تلفیق شروط در سه مرحلهی این چرخه است: ۱٫در مرحلهی «حس»، سیستم باید طوری توسعه پیدا کند که تمام عناصر محیطیِ لازم را برای اطمینان از پایبندی به شروط تشخیص دهد؛ ۲٫ در مرحلهی «برنامه»، سیستم فقط باید برنامههایی را ملاحظه کند که به شروط پایبندهستند؛ ۳٫ در مرحلهی «عمل»، اَعمال سیستم باید به رفتارهایی محدود باشد که شروط را برآورده میکنند.

مهندسی [هوش مصنوعی] همانطور که در بالا ترسیم شد بسیار عام است و از بیشتر سیستمهای هوش مصنوعی فقط توصیف ناقصی ارائه میدهد. با این وجود، برای موانع و سیاستهایی که باید در ماژولهای خاص انعکاس یابد نقطه اتکایی فراهم میکند تا به سیستمی کلی منتهی شود که اطمینانبخش و به این شکل متصور است.

. اخلاقپژوهی و حاکمیت قانون بر اساس طراحی (ایکس ـ پیشاپیش طراحیشده)

روشهایِ تضمینِ ارزشهای پیشاپیش طراحیشده، میان اصول انتزاعیای که سیستم ملزم به رعایت آنهاست و اجرای تصمیمات مشخص، ارتباطات دقیق و روشنی را برقرار میکنند. این تصور که پیروی از هنجارها را میتوان در طراحیِ سیستم هوش مصنوعی به اجرا درآورد در این روش امری کلیدی است. شرکتها مسئول شناسایی تأثیر سیستمهای هوش مصنوعی خود از همان ابتدا هستند، همچنین سیستم هوش مصنوعیِ آن شرکتها باید برای جلوگیری از تأثیرات منفی به هنجارهایی پایبندباشد. مفاهیم «پیشاپیش طراحیشده» متفاوت در حال حاضر در مقیاس وسیع استفاده میشوند، برای مثال، حریم خصوصیِ پیشاپیش طراحیشده و امنیتِ پیشاپیش طراحیشده. همانطور که بالا بیان شد، هوش مصنوعی برای جلب اطمینان به خود باید در مراحل پردازش، داده و بازدهی ایمن باشد و باید طوری طراحی شده باشد که در برابر دادهها و حملات دشمنانه مستحکم باشد. هوش مصنوعی باید سازوکاری داشته باشد که برای خودایمنی فعالیت خود را متوقف کند و سپس بتواند پس از متوقفکردنِ اجباری (مانند حمله) عملیات خود را از سر بگیرد.

.روشهای توضیحی

برای اینکه سیستمی اطمینانبخش باشد باید بتوانیم بفهمیم چرا به روش خاصی رفتار میکند و چرا تفسیری مشخص ارائه میدهد. توضیحپذیری هوش مصنوعی XAI)) در یک زمینهی تحقیقاتی کامل تلاش میکند به این موضوع بپردازد تا سازوکارهای زیربناییِ سیستم را بهتر بشناسد و راهحلهایی پیدا کند. امروزه، این چالش برای سیستمهای هوش مصنوعی مبتنی بر شبکههای عصبی مطرح است. فرآیندهای آموزشی با شبکههای عصبی میتوانند پارامترهای شبکهای را روی مقادیر عددیای تنظیم کنند که به دشواری با نتایج مرتبط هستند. علاوه بر این، گاهی تغییرات کوچک در مقادیر دادهها ممکن است به تغییرات چشمگیری در تفسیر منتهی شود و برای مثال باعث شود سیستم اتوبوس مدرسه را با شترمرغ اشتباه بگیرد. این آسیبپذیری میتواند هنگام حمله به سیستم نیز مورد سوءاستفاده قرار بگیرد. روشهای مربوط به تحقیقات XAI نهتنها برای توضیح رفتار سیستم برای کاربران، بلکه برای راهاندازیِ فناوریِ قابلاعتماد نیز حیاتیاند.

.تست و اعتبارسنجی

بهدلیل ماهیتِ غیریقینی و وابسته به بسترِ سیستمهای هوش مصنوعی، آزمایشِ سنتی کافی نیست. اِشکال در مفاهیم و بازنمودهایی که سیستم استفاده میکند ممکن است فقط زمانی آشکار شود که برنامهی روی دادههایی به کار رود که به حد کافی واقعبینانه هستند. در نتیجه، برای راستیآزمانی و اعتبارسنجیِ پردازشِ دادهها، الگوی زیربنایی باید هم حین آموزش و هم راهاندازی، پایداری، استحکام و عملکرد آن را در محدودههای پیشبینیپذیر و کاملاً مشخص با دقت نظارت کند. باید اطمینان حاصل کرد که بازده فرآیند برنامهریزی با ورودی مطابقت دارد و تصمیمات به گونهای گرفته میشوند که امکان اعتبارسنجی فرآیند زیربنایی را فراهم میکنند.

آزمایش و اعتبارسنجیِ سیستم باید در اسرع وقت انجام شود و تضمین شود که سیستم در تمام چرخهی حیات خود و بخصوص بعد از راهاندازی همانطوری رفتار میکند که قبلاً تعیین شده است. این آزمایش باید تمام مؤلفههای سیستم هوش مصنوعی، از جمله داده، الگوهایِ از پیش آموزشدیده، محیط و رفتار سیستم را بهطور کلی دربرگیرد. فرآیندهای آزمایش باید طراحی شوند و گروههای متعددی از افراد تا حد امکان آن را انجام دهند. برای پوشش مقولاتی که برای چشماندازهای متفاوت آزمایش میشوند باید معیارهایی چندگانه ایجاد شود. «تیمهای قرمزِ» مورداعتماد و متعدد آزمایش دشمنانهای ترتیب میدهند که در آن عمداً تلاش میکنند در سیستم خلل ایجاد کنند تا آسیبپذیریها را پیدا کنند؛ همچنین «برنامهی باگ بانتی7» را نیز میتوان در نظر گرفت تا افراد خارجی تشویق شوند خطاها و ضعف سیستم را شناسایی و مسئولانه گزارش دهند. نهایتاً باید تضمین شود که خروجیها یا کارهای سیستم با نتایج فرآیندهای پیشین سازگار است و آنها را با سیاستهای تعریفشدهی قبلی مقایسه کرد تا از نقضنشدنِ آنها مطمئن شد.

.شاخصهای کیفیتِ خدمات

برای اینکه تضمین شود فهم اولیه دربارهی این که آیا سیستمها با ملاحظات امنیتی و ایمنی آزمایش و توسعه یافتهاند، میتوان شاخصهای مناسبِ کیفیت خدمات را برای سیستمهای هوش مصنوعی تعریف کرد. این شاخصها میتوانند شامل معیارهایی برای ارزیابیِ آزمایش و آموزش الگوریتمها و همچنین معیارهای سنتیِ عملکرد، اجرا، استفادهپذیری، اعتمادپذیری، امنیت و ماندگاری نرمافزار باشند.

۲ـ ۲ روشهای غیرفنی

این بخش انوااع روشهای غیرفنی را توصیف میکند که میتوانند در ایمنکردن و ماندگاریِ هوش مصنوعی اطمینانبخش نقش ارزشمندی ایفا کنند. این دو باید بهصورت مستمر ارزیابی شوند.

.مقررات

همانطور که بالا بیان شد، مقرراتی برای پشتیبانی از اطمینانبخشیِ هوش مصنوعی در حال حاضر وجود دارد ـ قانونگذاری مربوط به ایمنیِ فرآورده و چارچوبهای مسئولیت را در نظر بگیرید. تا زمانی که در نظر بگیریم مقررات، هم در جایگاه محافظ و هم توانمندساز، ممکن است به بازنگری، سازگاری یا معرفی نیاز داشته باشند این موضوع در دومین دستاورد ما از جمله سیاستهای مربوط به هوش مصنوعی و سرمایهگذاری مطرح خواهد شد.

.منشور رفتاری

سازمانها و صاحبان منافع میتوانند دستورالعملها را ثبت کنند و اساسنامهی تعهدات شرکتی خود، شاخصهای کلیدیِ اجرایی، منشورهای رفتاری یا خطمشیِ داخلی خود را بهضمیمهی تلاش برای رسیدن به هوش مصنوعی اطمینانبخش را تنظیم کنند. سازمانی که با سیستمهای هوش مصنوعی یا روی آنها کار میکند، بهطور عامتری میتواند مقاصد خود را ثبت کند و همچنین آنها را با استانداردهایی از ارزشهای مطلوبِ معینی تضمین کند؛ ارزشهایی مانند حقوق اساسی، شفافیت و جلوگیری از آسیب.

.استانداردسازی

استانداردها، برای مثال، در زمینهی طراحی، تولید و شیوههای تجارت میتوانند در نقش مدیریت کیفیت سیستم برای کاربران هوش مصنوعی، مصرفکنندگان، سازمانها، مؤسسات تحقیقاتی و حکومتها عمل کنند؛ استانداردها در تصمیمات مربوط به خریدِ کاربران، با فراهمکردنِ توانایی تشخیص و تشویق آنها به رفتار اخلاقی این کار را انجام میدهند. فراتر از استانداردهای مرسوم، رویکردهای نظارتی مشترک وجود دارد: سیستمهای اعتباربخشی، منشور اخلاقپژوهیِ حرفهای یا استانداردهایی برای حقوق اساسیِ منطبق با طراحی. نمونههای کنونی برای مثال عبارتند از استانداردهای ISO یا مجموعه استانداردهای IEEE P7000، اما در آینده ممکن است برچسبِ «هوش مصنوعی اطمینانبخش» مناسبِ این کار باشد که با اشاره به استانداردهای فنیِ ویژه تأیید کند که آن سیستم برای مثال به ایمنی، استحکام فنی و شفافیت پایبنداست.

.صدور گواهینامه

از آنجایی که نمیتوان انتظار داشت همگان بتوانن کارها و اثرات سیستمهای هوش مصنوعی را کاملاً درک کنند، میتوان کار بررسی را به سازمانهایی سپرد که به عموم مردم بر تصدیق این امر گواهی دهند که سیستم هوش مصنوعی شفاف، پاسخگوو منصف است. این گواهینامهها استانداردهای توسعهیافته برای حوزههای کاربردیِ مختلف و فنون هوش مصنوعی را به کار میگیرند که با استانداردهای صنعتی و اجتماعیِ بسترهای مختلف همراستاست. با این حال، گواهینامه هرگز نمیتواند جای مسئولیتپذیری را بگیرد. بنابراین، مکمل آن باید چارچوبهای پاسخگویی از جمله تکذیبیهها و همچنین بازنگری و جبران خسارتِ سازوکارها باشد.

. پاسخگویی از طریق چارچوبهای حاکم

سازمانها باید چارچوبهای حاکم را، هم داخلی و هم خارجی، تنظیم کنند تا پاسخگوبودن آنها را در ابعاد اخلاقیِ تصمیمات مرتبط با توسعه، راهاندازی و استفاده از سیستمهای هوش مصنوعی تضمین کنند. برای مثال، انتصابِ شخصی که مسئولِ مسائل اخلاقپژوهی مربوط به سیستمهای هوش مصنوعی باشد، یا تشکیل هیئت منصفه یا مدیرهی داخلی/خارجی در اخلاقپژوهی. از جمله وظایف احتمالیِ چنین شخصیی، هیئت منصفه یا مدیره، نظارت و مشاوره است. همانطور که بالا در مقدمه مطرح شد، آییننامهی گواهینامه و نهادها نیز میتوانند در این راستا سهمی داشته باشند. کانالهای ارتباطی باید تضمین کنند که صنعت و/یا گروههای نظارت عمومی، بهترین شیوهها را به اشتراک میگذارند و دربارهی معضلات یا مسائل نوظهور در دغدغههای اخلاقی بحث میکنند. چنین سازوکارهایی میتوانند مکمل نظارتِ قانونی باشند، اما نمیتوانند جای آن را بگیرند (مثلاً فرم انتصابِ افسرِ حفاظت از دادهها یا اقدامات مشابه که طبق قانونِ حفاظت از داده قانوناً لازم است).

.آموزش و آگاهی برای پروراندنِ طرز فکر اخلاقی

هوش مصنوعی اطمینانبخش، همهی صاحبان منافع را به مشارکتِ آگاهانه تشویق میکند. ارتباطات، آموزش و پرورش نقش مهمی ایفا میکنند، هم در تضمین این که دانشِ مربوط به تأثیرات احتمالیِ سیستمهای هوش مصنوعی، دانشی وسیع است و هم برای آگاهساختن افراد به این که آنها میتوانند در رفتارسازیِ توسعهی اجتماعی مشارکت کنند. این امر دربارهی تمامی صاحبان منافع صادق است، برای مثال کسانی که در تولید فرآوردهها دخالت دارند (طراحان و توسعهدهندگان)، کاربران (شرکتها یا افراد) و سایر گروههایِ تحت تأثیر (کسانی که ممکن است سیستم هوش مصنوعی را خریداری یا استفاده نکنند، اما سیستم هوش مصنوعی برای آنها تصمیم میگیرد و جامعه بهطور کلی). سواد اولیه مربوط به هوش مصنوعی باید در تمامی جامعه تقویت یابد. لازمهی آموزشِ همگانی، اطمینانیافتن از مهارتها و تربیتِ مناسب اخلاقپژوهان در این حوزه است.

.مشارکت صاحبان منافع و گفتگوی اجتماعی

مزایای سیستمهای هوش مصنوعی بسیار زیاد اسات و اروپا باید تضمین کند که آنها در دسترس همگان قرار گیرند. این امر مستلزم بحثی آزاد و مشارکت شرکای اجتماعی و صاحبان منافع، از جمله عموم مردم است. بسیاری از سازمانها در حال حاضر برای بحث در زمینهی استفاده از سیستمهای هوش مصنوعی و تجزیه و تحلیل دادهها به هیئت منصفهی صاحبان منافع وابسته هستند. این هیئتهای منصفه اعضای متفاوتی دارند؛ از جمله کارشناسان حقوقی، فنی، اخلاقپژوهان، نمایندگانِ مصرفکنندگان و کارگران. اینکه درصددِ مشارکت و گفتگوی فعالانه دربارهی تأثیرات سیستمهای هوش مصنوعی باشیم از ارزیابی نتایج و رویکردها پیشتیبانی میکند و بهویژه در موارد پیچیده میتواند مفید باشد.

.تیمهای طراحی متنوع و همهشمول

هنگامِ توسعهی سیستمهای هوش مصنوعی که در جهان واقعی به کار گرفته میشوند تنوع و همهشمولی نقش اساسی ایفا میکنند. از آنجایی که سیستمهای هوش مصنوعی خودشان کار بیشتری انجام میدهند، بسیار مهم است تیمهایی که این سیستمها را طراحی، توسعه، آزمایش و نگهداری، راهاندازی و تهیه میکنند در آن سیستمها تنوع کاربران و بهطور کلی تنوع جوامع را انعکاس دهند. این امر به عینیتیافتن و درنظرگرفتنِ چشماندازهای متفاوت کمک میکند. در حالت ایدئال، تیمها نهتنها از نظر جنسیت، فرهنگ و سن، بلکه از نظر سوابق حرفهای و مجموعه مهارتها نیز متنوع هستند.

راهنمای کلیدی برگرفته از فصل دوم:

- تضمین کنید که کل چرخهی حیات سیستم هوش مصنوعی، هفت شرط کلیدیِ هوش مصنوعی اطمینانبخش را برآورده میکند: ۱.عامل انسانی و نظارت، ۲.استحکام فنی و ایمنی، ۳.حریم خصوصی و سازماندهی داده، ۴.شفافیت، ۵.تنوع، نبودِ تبعیض و انصاف، ۶.رفاه اجتماعی و محیطی، ۷. پاسخگویی

- برای تضمینِ اجرای آن شروط به روشهای فنی و غیرفنی توجه کنید.

- تحقیق و نوآوری را تقویت کنید تا به ارزیابی سیستمهای هوش مصنوعی و تحقق هر چه بیشتر شروط، انتشار نتایج و ایجادکردنِ پرسشهایی برای طیف گستردهای از عمومِ افراد و آموزش نظاممندِ نسل جدیدی از متخصصان در زمینهی اخلاقپژوهیِ هوش مصنوعی کمک کند.

- دربارهی قابلیتها و محدودیتهای سیستم هوش مصنوعی به طریقی روشن و پویشگرانه به صاحبان منافع اطلاعاتی را منتقل کنید، تنظیم انتظاراتی واقعبینانه را میسر سازید و دربارهی طریقهی برآوردهشدن شروط به صاحبان منافع اطلاعات دهید. دربارهی این واقعیت که آنها با سیستم هوش مصنوعی سروکار دارند، شفاف باشید.

- قابلیت ردیابی وقابلیتِ بازرسی سیستمهای هوش مصنوعی را بهویژه در بسترها و موقعیتهای بحرانی تسهیل کنید.

- صاحبان منافع را در طول چرخهی حیات سیستم هوش مصنوعی درگیر کنید. آموزش و پرورش را تقویت کنید تا تمام صاحبان منافع دربارهی هوش مصنوعی اطمینانبخش آگاهی یابند و آموزش ببینند.

- متوجه باشید که ممکن است بین اصول و شروط مختلف تنشهای اساسی رخ دهد. این معاوضات و راهحلهای آنها را مُدام شناسایی، ارزیابی، ثبت و ابلاغ کنید.

فصل سوم: ارزیابی هوش مصنوعیِ اطمینانبخش

بر اساس شروط کلیدی در فصل دوم، این فصل به تنظیم فهرستی نه چندان جامع در ارزیابی هوش مصنوعی اطمینانبخش (نسخهی آزمایشی) را برای عملیاتیکردنِ هوش مصنوعی اطمینانبخش میپردازد. این ارزیابی بهویژه برای سیستمهای هوش مصنوعی کاربرد دارد که مستقیماً با کاربران در ارتباط هستند و عمدتاً به توسعهدهندگان و راهاندازانِ سیستمهای هوش مصنوعی فرستاده میشود (چه خودساخته باشند و چه از طریق اشخاص سومی بدست آمده باشند). این فهرست ارزیابی به عملیاتیسازیِ اولین مؤلفه از هوش مصنوعی اطمینانبخش (هوش مصنوعی قانونی) نمیپردازد. تبعیت از این فهرست ارزیابی مدرکی بر تبعیت قانونی نیست، راهنمایی برای تضمینِ تبعیت از قوانین اجراپذیر هم نیست. با توجه به کاربرد خاصِ سیستمهای هوش مصنوعی، طراحیِ فهرست ارزیابی باید برای موارداستفادهی خاص و بستری که سیستم در آن عمل میکند متناسب باشد. علاوه بر این، این فصل دربارهی نحوهی عملیاتیکردن فهرست ارزیابی برای هوش مصنوعی اطمینانبخش با ارائهی ساختار سازماندهی هم در مرتبهی عملیاتی و هم در مرتبهی مدیریت توصیههای کلی پیشنهاد میدهد.

فهرست ارزیابی و ساختار سازماندهی از طریق همکاری نزدیک با صاحبان منافع در سراسر بخش خصوصی و دولتی توسعه خواهد یافت. این فرآیند، فرآیندی آزمایشی تلقی میشود و بازخورد گسترده از دو فرآیند موازی را در نظر میگیرد:

الف) فرآیند کیفی، تضمینِ قابلیتِ نمایندگی که در آن تعداد کمی از شرکتها، سازمانها و مؤسسات (کوچک و بزرگ و از بخشهای مختلف) ثبتنام میکنند تا فهرست ارزیابی و ساختار سازماندهی را عملاً آزمایش کنند و بازخوردی جامع و دقیق ارائه دهند؛

ب)فرآیند کمی که در آن صاحبانِ منافعِ علاقهمند میتوانند ثبتنام کنند تا فهرست ارزیابی را آزمایش کنند و در مشاورهای رایگان بازخورد ارائه دهند.

پس از مرحلهی آزمایشی، ما نتایج حاصل از فرآیند بازخورد را با فهرست ارزیابی ادغام کرده و نسخهی اصلاحی را در اوایل ۲۰۲۰ تهیه میکنیم. هدف از این مرحله، دستیابی به چارچوبی است که بتوان بهصورت همتراز در تمام برنامههای کاربردی از آن استفاده کرد و در نتیجه مبنایی برای تضمین هوش مصنوعی اطمینانبخش در تمامی حوزهها فراهم کرد. وقتی چنین مبنایی فراهم شود، چارچوبی مختصِ برنامهی کاربردی یا چارچوبِ [چند]بخشی8 امکانِ توسعه مییابد.

.سازماندهی

صاحبان منافع ممکن است بخواهند این امر را بررسی کنند که چگونه فهرست ارزیابی هوش مصنوعی اطمینانبخش میتواند در سازمانهای آنها اجرا شود. این مقصود را میتوان با تلفیق فرآیند ارزیابی در سازوکارهای سازماندهی موجود یا با عملیاتیکردن فرآیندهای جدید انجام داد. این انتخاب به ساختار درونی سازمانها، کوچک و بزرگی آنها و منابع دردسترس بستگی دارد.

تحقیقات نشان میدهد که توجهِ مدیریت در بالاترین سطح برای دستیابی به تغییر ضروری است. همچنین نشان میدهد تمامی صاحبانِ منافعِ مشغول در شرکت، سازمان یا مؤسسه، پذیرش و اهمیتِ معرفیِ هر فرآیند جدیدی را (خواه فناورانه باشد یا نباشد) ترویج میکنند. بنابراین، ما اجرایِ فرآیندی را توصیه میکنیم که هم در مرتبهی عملیاتی و هم در مرتبهی مدیریت ارشد نقش داشته باشد.

| مرتبه | نقشهای مرتبط (وابسته به سازمان) |

|---|---|

| مدیر و هیئت مدیره | مدیران ارشد دربارهی توسعه، راهاندازی یا تدارک سیستمهای هوش مصنوعی بحث و آن را ارزیابی میکنند و زمانی که اختلالات و تنشهای اساسی شناسایی میشوند هیئت تعدیل را به خدمت میگیرند برای ارزیابی تمامی نوآوریها و کاربردهای هوش مصنوعی. هیئت تعدیل کسانی هستند که در طول فرآیند از طریق اطلاعات، مشاوره و رویههای مشارکت تحت تأثیر معرفی احتمالیِ سیستمهای هوش مصنوعی (برای مثال کارگران) و نمایندگانِ آنها قرار گرفتهاند. |

| تبعیت/ قانونیبودن بخش/ مشارکتی بخشِ مسئولیتپذیری | بخش مسئولیتپذیری بر استفاده از فهرست ارزیابی و تحولات ضروریِ آن برای برآوردهکردن تغییراتِ فناورانه یا قانونگذارانه نظارت دارد. این بخش استانداردها یا خطمشیهای داخلی سیستمهای هوش مصنوعی را بهروزرسانی میکند و تضمین میکند که استفاده از چنین سیستمهایی از چارچوب قانونی و نظارتیِ فعلی و از ارزشهای سازمان تبعیت میکند. |

| توسعهی خدمات و فرآورده یا مشابه آن | بخش توسعه خدمات و فرآورده از فهرست ارزیابی استفاده میکند تا فرآوردهها و خدماتِ مبتنی بر هوش مصنوعی را بررسی کند و تمام نتایج را ثبت کند. دربارهی این نتایج در بخش مدیریت بحث شده است که نهایتاً برنامههای کاربردیِ هوش مصنوعیِ جدید یا اصلاحشده را تأیید میکند. |

| تضمین کیفیت | بخش تضمین کیفیت (یا مشابه آن) نتایجِ فهرست ارزیابی را تضمین و بررسی میکند و در صورتی که نتایج رضایتبخش نباشند یا نتایجِ پیشبینیناشدهای شناسایی شوند برای کاهشِ تنش مربوطه در مرتبهی بالاتر وارد عمل میشود. |

| منابع انسانی | بخش منابع انسانی ترکیب درستِ شایستگیها و وجهههای متعدد را برای توسعهکنندگان سیستمهای هوش مصنوعی تضمین میکند. این بخش تضمین میکند که درونِ سازمان، سطح مناسب آموزش به هوش مصنوعیِ اطمینانبخش محقق میشود. |

| تدارکات | بخش تدارکات تضمین میکند که فرآیند تدارکِ فرآوردههای مبتنی بر هوش مصنوعی نیز بر هوش مصنوعیِ اطمینانبخش نظارت میکند. |

| عملیات روزانه | توسعهدهندگان و مدیران پروژه فهرست ارزیابی را در کار روزانهی خود میگنجانند و نتایج و برآوردهای ارزیابی را ثبت میکنند. |

.استفاده از فهرست ارزیابی هوش مصنوعیِ اطمینانبخش

توصیه میکنیم هنگامی که عملاً از فهرست ارزیابی استفاده میکنید نهتنها به حوزههای مورد توجه، بلکه به پرسشهایی توجه کنید که بهآسانی نمیتوان به آنها پاسخ داد. یکی از مسائل احتمالی ممکن است این باشد که تیمِ توسعهدهنده و آزمایشگرِ سیستم هوش مصنوعی مهارتها و شایستگیهای متعددی نداشته باشند و بنابراین چهبسا ضروری باشد سایر صاحبان منافع در داخل یا خارج از سازمان مشغول به کار شوند. اکیداً توصیه میشود تمامی نتایج هم از نظر فنی و هم مدیریتی ثبت شوند تا اطمینان حاصل شود که حلِ مسئله را در تمام مراتب ساختار سازماندهی میتوان فهمید.

این فهرست ارزیابی به منظور راهنماییِ متخصصان هوش مصنوعی برای دستیابی به هوش مصنوعیِ اطمینانبخش است. ارزیابیِ موارد استفادهی خاص باید به روشی مناسب تنظیم شود. در طول مرحلهی آزمایشی، حوزههایی که حساسیت خاصی دارند ممکن است آشکار شوند و نیاز به جزئیات ضروریِ بیشتر در چنین مواردی در مراحل بعدی ارزیابی خواهد شد. در حالی که این فهرست ارزیابی به پرسشهای مطرحشده پاسخ مشخصی نمیدهد، ولی ما را به تأمل دربارهی این که چگونه میتوان هوش مصنوعی اطمینانبخش را به مرحلهی اجرا درآورد و همچنین تأمل دربارهی اقدامات احتمالیای تشویق میکند که باید در این زمینه برداشته شود.

.ابلاغ فرآیندها و قوانینِ موجود

همچنین برای متخصصان هوش مصنوعی تشخیص این امر مهم است که قوانین مختلفی وجود دارند که فرآیندهای خاصی را الزامی میکنند یا مانع از بروز نتایجی خاص میشوند که ممکن است با برخی از اقداماتی همپوشانی داشته باشند که در فهرست ارزیابی مطرح شده است. برای مثال، قانون حفاظت از داده، مجموعهای از شروط قانونی را تعیین میکند که افرادِ مشغول در گردآوری و پردازش دادههای شخصی باید آن شروط را رعایت کنند. در عین حال، از آنجایی که هوش مصنوعی اطمینانبخش همچنین مستلزم مدیریت اخلاقی دادههاست، سیاستها و رویههای داخلی با هدف تضمینِ تبعیت از قوانینِ حفاظتِ داده نیز میتوانند به تسهیلِ مدیریت اخلاقی دادهها کمک کنند و از این رو میتوانند فرآیندهای قانونی موجود را تکمیل کنند. با این حال، تبعیت از این فهرست ارزیابی، شاهدی بر تبعیت قانونی نیست، همچنین راهنمایی برای تضمینِ تبعیت از قوانین اجراشدنی نیست.