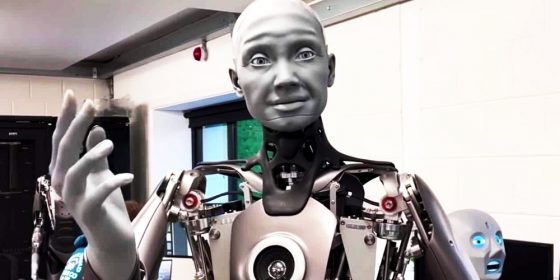

همزیستی نهچندان مسالمتآمیز هوش مصنوعی و حقوق بشر

در حوزهٔ هوش مصنوعی روزبهروز پیشرفتهایی بیشتر حاصل میشود. در چند سال گذشته اتفاقهایی رخ دادهاند که نشان میدهند حقوق بشر چندین بار بهوسیلهٔ همین فناوری هوش مصنوعی، نقض شدهاست.

برای تشخیص گفتار در فضای اینترنت الگوریتمهایی طراحی شدهاند. این الگوریتمها گفتار کاربران را سانسور کردهاند. موضوع سانسور مسائلی متنوع بودهاست، از محتواهای مذهبی گرفته تا مسائل مرتبط به تنوع در گرایشهای جنسی. سامانههای هوش مصنوعی که طراحی شدهاند تا فعالیتهای غیرقانونی را رصد کنند، در جایی دیگر به کار گرفته شدهاند تا این بار فعالان حقوق بشری را تحت تعقیب قرار بدهند و هدف بگیرند. الگوریتمهایی را هم به کار بردهاند تا انواع سرطان را تشخیص بدهند. همچنین از الگوریتمهایی استفاده کردهاند تا ببینند آندسته از افرادی که متهم به ارتکاب جرم شدهاند، چه اندازه امکان دارد که پا به فرار بگذارند. این الگوریتمها علیه سیاهپوستان تبعیض روا داشتهاند. فهرست خطاهایی از این دست بسیار طولانیتر از اینهاست.

برای تشخیص گفتار در فضای اینترنت الگوریتمهایی طراحی شدهاند. این الگوریتمها گفتار کاربران را سانسور کردهاند.

ما پژوهشگرانی هستیم که موضوع تحقیقمان، نقطهٔ تلاقی هوش مصنوعی و عدالت اجتماعی است، به همین جهت راهکارهایی را آزمودهایم که هدف از آنها، پاسخگفتن به رویههای ناعادلانهٔ هوش مصنوعی بودهاست. نهایتاً به این نتیجه رسیدهایم که هیچیک از این راهکارها چنگی به دل نمیزنند.

اخلاقیات و ارزشها

برخی شرکتها خودخواسته چارچوبی اخلاقی اتخاذ کردهاند. اعمال و عملیاتیسازی این قبیل چارچوبهای اخلاقی دشوار است و تأثیر عینی و قطعی آنها اندک. علت آن نیز ریشه در دو مسئله دارد. نخست اینکه اخلاق بر پایهٔ ارزش است که بنا میشود، نه بر پایهٔ حقوق و اینکه ارزشهای اخلاقی غالباً طیفی وسیع را در بر میگیرند و با یکدیگر متفاوتاند. مسئلهٔ دوم این است که چنین چارچوبهایی ضمانت اجرایی ندارند، لذا اگر سامانهای از حقوق بشر تخطی کند و آن را زیر پا بگذارد، مردم نمیتوانند شرکت را مسئول آن خطای پیشآمده بدانند.

چارچوبهایی هم هستند که اجباریاند، نظیر ابزار سنجش تأثیر الگوریتمی در کشور کانادا. اینقبیل چارچوبها هم در واقع بیشتر شبیه به دستورالعملهایی هستند که استفاده از بهترین رویهها را تشویق میکنند و بس. در نهایت رویکردهای خودتنظیمی هم تأثیر اندکی دارند و تأثیر آنها فقط کمی بیشتر است از حالتی که در آن، تنظیم و اعمال قوانینی به تأخیر افتاده که بر استفاده از هوش مصنوعی نظارت دارند.

حتی تلاشهایی که در این زمینه صورت گرفته و هدف از آن، وضع چنین قوانینی بوده، موانع و معایب خود را داشتهاست. نمونهٔ آن هم اتحادیهٔ اروپاست که بهتازگی قوانینی برای هوش مصنوعی ارائه کرد. موانع و معایبی که ذکرش رفت، در این اقدام هویدا بود. این لایحهٔ قانونی ابتدا انواع کاربردهای هوش مصنوعی را لحاظ میکند و میسنجد که هر یک از این کارکردها، تا چه اندازه میتوانند مایهٔ ایجاد تهدید و خطر باشند؛ سپس نسبت به میزان خطری که هر فناوری میتواند ایجاد کند، محدودیتها و مقرراتی برایش وضع میکند.

اینکه بهکاربردن نوعی از فناوری هوش مصنوعی خطر عملیاتی پایینی داشته باشد، بدان معنا نیست که بهلحاظ حقوق بشری نیز مایهٔ هیچنوع مخاطرهای نباشد.

سازمانی ناسودبر به نام اکسس نَو 1 وجود دارد که در زمینهٔ حقوق فضای دیجیتال فعالیت میکند. بهگفتهٔ این سازمان چنین رویکردی آنچنان که بایدوشاید از حقوق بشر دفاع نمیکند. این قانون دست شرکتها را باز میگذارد تا از فناوریهای مختلف هوش مصنوعی استفاده کنند، مادامی که فعالیت این فناوریها مخاطرات کمی بههمراه داشته باشند.

اینکه بهکاربردن نوعی از فناوری هوش مصنوعی خطر عملیاتی پایینی داشته باشد، بدان معنا نیست که بهلحاظ حقوق بشری نیز مایهٔ هیچنوع مخاطرهای نباشد. چنین رویکردی برای قانونگذاری ماهیتاً و از اساس، بر پایهٔ نابرابری و بیعدالتی شکل گرفتهاست. این قانون از رویهای نشأت گرفته که فرض میگیرد حقوق بنیادین بشری، مسائلی هستند قابلمذاکره و موضوع بحث.

حضور فناوری در زندگی ما روزبهروز پررنگتر شدهاست و به شیوههایی بروز و ظهور یافته که از بیخوبن، ماهیت و کیفیت حقوق ما را دگرگون ساختهاست

سؤال کماکان بر جای خود باقی است: چرا قانون اجازه میدهد که حقوق بشر اینگونه زیر پا گذاشته شوند؟ بسیاری از کشورها چهارچوبها و قواعدی دارند که از حقوق و آزادیهای فردی شهروندان خود دفاع میکنند، اما از چنین حقوقی تنها دربرابر تعدیهای دولتی است که حفاظت میشود و بس. شرکتهایی که سامانههای هوش مصنوعی را میسازند، موظف نیستند تا آزادیهای بنیادین و اساسی ما را مد نظر قرار داده و حرمتشان را حفظ کنند. حضور فناوری در زندگی ما روزبهروز پررنگتر شدهاست و به شیوههایی بروز و ظهور یافته که از بیخوبن، ماهیت و کیفیت حقوق ما را دگرگون ساختهاست، بهرغم اینها، چنین واقعیتی که شرکتها حقوقمان را نقض میکنند، کماکان بر جای خود باقی است.

تخطیهای هوش مصنوعی

ما از سامانههای هوش مصنوعی استفاده میکنیم. در این میان ممکن است بهسبب استفادهٔ خودمان، حقوقمان نقض شود و بخواهیم از این حقوق دفاع کرده، آنها را اعاده کنیم، ولی واقعیت جهانی که امروزه در آن زندگی میکنیم به گونهای است که دست ما را برای انجام این کار میبندد و مانع از این میشود که خود، در این میان نقشی ایفا کنیم. در نتیجه، به معنای واقعی کلمه «آن وجه از قانون حقوق بشر که به فرد امکان میدهد تا به عدالت دسترسی داشته باشد، خنثی میشود»؛ به عبارت دیگر لزوماً قرار نیست که تخطی از حقوق بشر، به جبران خسارت قربانیان بینجامد یا منجر شود به این تضمین که در آینده دیگر از این حقوق تخطی نخواهد شد. همهٔ اینها در صورتی است که قانون چنین چیزی را طلب نکند.

ولیکن حتی قوانینی که در جهت حقوق بشر وضع شدهاند، اغلب به همین نتایج منجر میشوند. برای مثال قانون عمومی حفاظت از دادههای اتحادیهٔ اروپا را در نظر بیاورید. این قانون به کاربران امکان میدهد تا اطلاعات و دادههای شخصی خود را خودشان مدیریت کنند و شرکتها را ملزم میسازد تا آن حقوق را مراعات کنند. این قانون گامی است مهم بهسوی حفاظت جدی از دادههای افراد در فضای مجازی، ولی آن تأثیر مطلوبی را که میبایست داشته باشد، بههمراه نداشته است. دلیل آن نیز ریشه در دو مسئله دارد.

لزوماً قرار نیست که تخطی از حقوق بشر، به جبران خسارت قربانیان بینجامد یا منجر شود به این تضمین که در آینده دیگر از این حقوق تخطی نخواهد شد.

نخست این است که راهکارهای مطلوب جهت انجام این کار، همیشه و تحت هر شرایطی به کاربران اجازه نمیدهند تا تماموکمال از حقوق بشری خود بهره ببرند. دوم این است که کاربران را توانمند نمیسازند و به آنها آگاهی و آموزش نمیدهند که بفهمند حفاظت از دادهها و اطلاعات شخصیشان حائز چه اهمیتی است و انجام این کار چه ارزشی دارد. برخی میپندارند که حقوق حفظ حریم خصوصی بهمعنی این است که کسی چیزی دارد و میخواهد آن را پنهان کند، پس به این حقوق اتکا میکند، اما موضوع حقوق حفظ حریم خصوصی بسیار گستردهتر از اینهاست.

لحاظکردن سوگیریها

این رویکردها که در قانونگذاری لحاظ میشوند، همه در پی آن هستند تا حد وسط را بگیرند؛ یعنی از سویی جانبِ منافع و خواستههای شهروندان را حفظ کنند، از سوی دیگر هم منافع و خواستههای شرکتها را در نظر بیاورند و در این میان وفاقی ایجاد کنند. سعی دارند به محافظت از حقوق بشر بپردازند و در عین حال ترتیبی بدهند که آندسته از قوانینی که بهتصویب میرسند و اجرا میشوند، مانع از پیشرفت فناوری نگردند. اما اقدام جهت حفظ این توازن معمولاً منجر میشود به حفاظتی ظاهری و جزئی از حقوق افراد، بدون آنکه تدابیر دفاعی و حفاظتی قرصومحکمی ارائه شود که مدافع آزادیهای بنیادین شهروندان باشد.

اگر میخواهیم به چنین تدابیری دست پیدا کنیم، لازم است وقتی به راهکاری میرسیم و میخواهیم مطابقش عمل کنیم، آن راهکار را با نیازها و منافع افراد تطبیق داده، سازگار کنیم، نه اینکه پیش خودمان فرض بگیریم که چنان منافعی چه هستند و بر پایهٔ همان حدسوگمانها و فرضیات دست به اقدام بزنیم. ضمناً هر راهکاری باید مشارکت شهروندان را نیز در بربگیرد.

موقع تعریف این راهکارها و قوانین باید حقوق بشر را مد نظر قرار داد تا اینگونه اطمینان حاصل شود که تدابیر حفاظتی و دفاعی مناسب و متناسب اتخاذ میگردند.

رویکردهایی که قانونگذاران اتخاد میکنند، تنها بهدنبال این هستند تا عوارض جانبی و منفی فناوری را قانونمند کنند و برای آن بخشها قوانینی طرح بریزند. این رویکردها در پی آن نیستند تا به سوگیریهای ایدئولوژیک و جامعهشناختی فناوری پاسخ دهند. اما وقتی فناوری حقوق بشر را نقض میکند، اینکه بیاییم و به موارد نقض حقوق بشر بپردازیم، آن هم پس از وقوع ماجرا، کارمان اصلاً کافی نیست. راهکارهای مبتنی بر فناوری باید در وهلهٔ نخست بر اساس اصولی شکل بگیرند نظیر عدالت اجتماعی و کرامت انسانی، نه بر اساس مخاطراتی که فناوری بههمراه دارد. موقع تعریف این راهکارها و قوانین باید حقوق بشر را مد نظر قرار داد تا اینگونه اطمینان حاصل شود که تدابیر حفاظتی و دفاعی مناسب و متناسب اتخاذ میگردند.

یکی از رویکردهایی که امروزه دارد بیشتر و بیشتر توجهها را به خود جلب میکند، «طراحی بر اساس حقوق بشر» است. این رویکرد یعنی اینکه «شرکتها مطابق الگوی تجاری خود، هیچنوع سوءاستفاده یا تبعیض را مجاز برنمیشمارند»، بلکه «تمام تلاش خود را به کار میبندند تا ابزارها، فناوریها و خدماتی را طراحی کنند که از اساس حقوق بشر را ارج مینهند و مراعات میکنند».

این رویکرد برنامهنویسان و سازندگان فناوریهای هوش مصنوعی را به سمتوسویی سوق میدهد که در آن، طی هر مرحله از انجام کار، حقوق بشر بهصورت اساسی و تماموکمال در کانون توجه افراد باشد. چنین رویکردی باعث میشود خاطرجمع شویم که آندسته از الگوریتمهایی که در جامعه به کار گرفته میشوند، به جای اینکه بر نابرابریهای اجتماعی بیفزایند و وضع آنها را بدتر کنند، مرهمی میشوند بر این نابرابریها و از میزانشان میکاهند. این رویکرد هدفی را مد نظر دارد و برای تحقق آن، گامهایی لازم بهسویش برمیدارد؛ هدف رویکرد حاضر این است که ما به هوش مصنوعی سروشکل بدهیم، نه اینکه هوش مصنوعی به زندگیهای ما جهت بدهد.